BERT模型中“cased“和“uncased“的区别

BERT模型中“cased“和“uncased“的区别

zhangjiqun

发布于 2025-06-14 08:53:40

发布于 2025-06-14 08:53:40

BERT模型中"cased"和"uncased"的区别

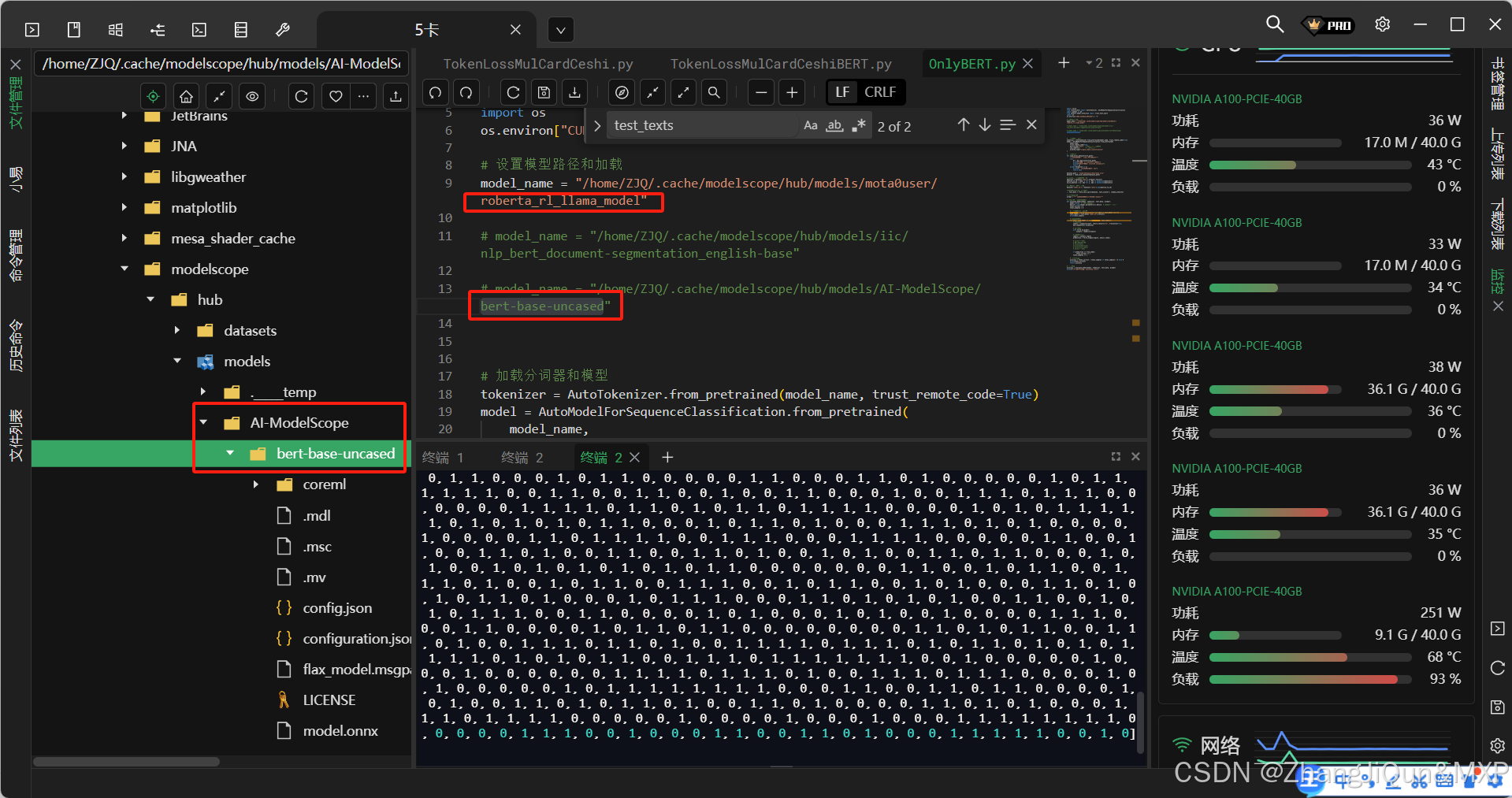

在BERT模型命名中,"cased"和"uncased"是两个重要的参数,它们的区别在于是否保留输入文本的大小写:

- BERT-base-uncased:在预处理阶段会将所有文本转换为小写(lowercased)

- BERT-base-cased:保留输入文本的原始大小写形式

具体区别

- 词汇表大小:

- uncased版本:词汇表通常较小,因为大小写不同的词(如"Apple"和"apple")被视为同一个词

- cased版本:词汇表更大,因为大小写不同的词被视为不同的词

- 适用场景:

- uncased:适合对大小写不敏感的任务,如情感分析、主题分类等

- cased:适合对大小写敏感的任务,如命名实体识别(NER)、词性标注等

- 训练数据处理:

- uncased模型在训练前会将所有文本转换为小写

- cased模型保留原始大小写,因此能够学习到大小写所携带的语义信息

为什么选择uncased?

在情感分析任务中,通常选择uncased版本,原因如下:

- 大小写通常不影响情感判断:

- "This movie is great!"和"This MOVIE IS GREAT!"表达的情感相同

- uncased模型可以减少词汇表大小,提高训练效率

- 减少过拟合风险:

- 将大小写不同但含义相同的词视为同一个词,可以增加数据的泛化性

- 与大多数英语语料库一致:

- 许多英文语料库在预处理时会转换为小写,与uncased模型更匹配

如果您的任务确实需要区分大小写(如区分人名、地名等),则应该选择cased版本的模型。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-06-13,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录