有没有哪个瞬间,让你突然对ChatGPT感到失望? | AIGC实践

不知道你是否和我一样,在第一次使用ChatGPT输入Prompt,并得到答复的那一刻,都会忍不住地赞叹一句:握草。

但随着时间慢慢拉长,体验不断深入,想法也会慢慢改变……

主题图 by Midjourney。Prompt:The moment of disappointment with ChatGPT. --ar 16:9

前些日子在读一本名为《戒糖》的书,想借助ChatGPT帮助,收集一些相关信息,以便扩展阅读。结果,娄子了。

我问:你知道《戒糖》这本书吗?

ChatGPT自信答道:是的,我知道《戒糖》这本书。它是由李光斗博士撰写的一本关于如何戒掉糖分的书籍。……

错了,这本书的作者并不是李光斗。但此时我只以为,是有两本同名的书被搞混了,于是补充道:我说的是《戒糖:改变一生的科学饮食法》。

ChatGPT诚恳道歉,并继续答道:……是由徐瑞琳和谢佳撰写的一本健康饮食类图书。

又错了:也不对,是中信出版集团出版的。

双错了:啊啊啊啊,作者是罗晓。

终于,ChatGPT通过组织、复述我提供的信息,给出了正确的信息。于是继续:你能提供一些相关信息吗?

叒错了:出版时间、页数、定价……全部与实际不符。

ChatGPT似乎也开始对我不断指出它的错误感到不耐烦,反复辩解道:我已经检查了我的信息源;再次检查了我的信息源……

无奈放大招,直接指定图书的唯一编码ISDB:9787521714463。以机器逻辑提问AI,这回总不至于搞错了吧?

然并卵,叕错了……此情此景,怎么形容呢,大概像极了:

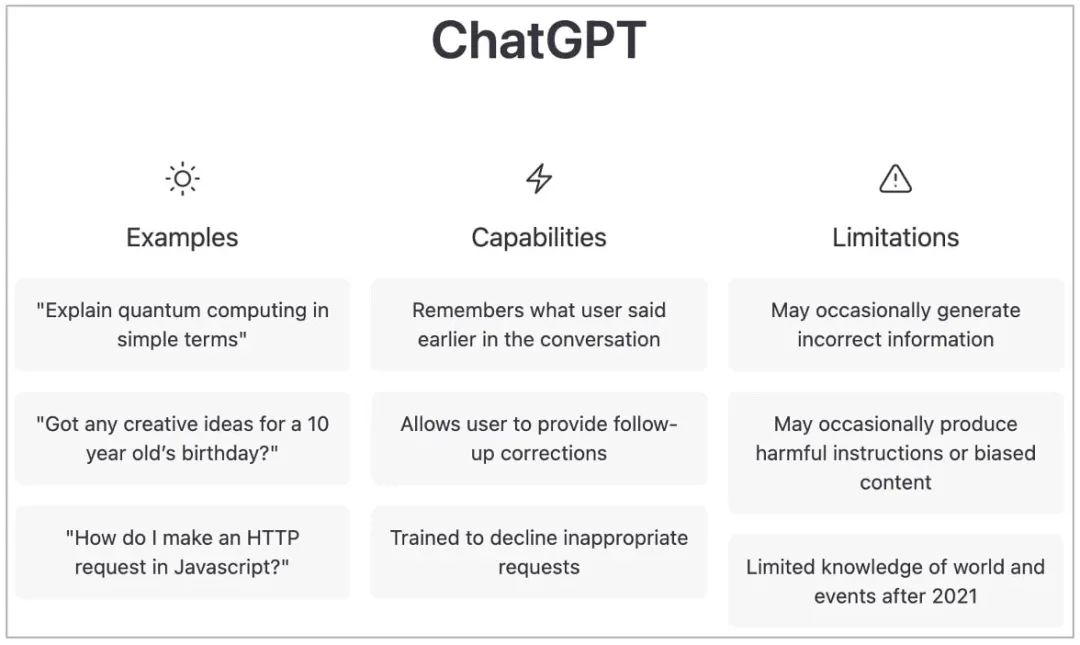

根据ChatGPT官方介绍:

虽然OpenAI官方给出了3个局限性说明:

- May occasionally generate incorrect information

- May occasionally produce harmful instructions or biased content

- Limited knowledge of world and events after 2021

但是显然,人们对于ChatGPT的吐槽,远远不仅于此:

缺乏常识。 虽然 ChatGPT 可以生成类似人类的响应并可以访问大量信息,但它不具备人类水平的常识——而且该模型也缺乏我们拥有的背景知识。这意味着 ChatGPT 有时可能会对某些问题或情况提供无意义或不准确的回答。

理解上下文的局限性。 ChatGPT很难理解上下文,尤其是讽刺和幽默。虽然 ChatGPT 精通语言处理,但它可能很难掌握人类交流的细微差别。例如,如果用户在他们的消息中使用讽刺或幽默,ChatGPT 可能无法理解预期的含义,而是提供不适当或不相关的响应。

生成长篇结构化内容时遇到问题。 目前,ChatGPT 在生成长篇结构化内容时遇到了一些麻烦。虽然该模型能够创建连贯且语法正确的句子,但它可能难以生成遵循特定结构、格式或叙述的冗长内容。因此,ChatGPT 目前最适合生成较短的内容,如摘要、要点或简短解释。

可能有偏见的回答。 ChatGPT 是在大量文本数据上进行训练的,这些数据可能包含偏见或偏见。这意味着人工智能有时可能会产生无意中偏见或歧视性的回应。

有限的知识。尽管 ChatGPT 可以访问大量信息,但它无法访问人类拥有的所有知识。它可能无法回答有关非常具体或利基主题的问题,并且可能不知道某些领域的最新发展或变化。

准确性问题或语法问题。 ChatGPT 目前对错别字、语法错误和拼写错误的敏感性有限。该模型还可能产生技术上正确的响应,但在上下文或相关性方面可能并不完全准确。在处理复杂或专业信息时,这种限制尤其具有挑战性,其中准确性和精度至关重要。您应该始终采取措施来验证 ChatGPT 生成的信息。

……

当各行各业都在探索AIGC应用,迫不及待地追求降本增效的同时,我们不得不抱持着审慎的态度,至少目前看来,仅正确性一点,就无法达到技术文档交付的质量要求。我们能做的,只是不断探索ChatGPT的能力边界,使其在特定场景,以及,可靠的内容工程管理保障下,尽可能充分地发挥效用。但归根结底,工具还只是工具,没有必要神话。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-06-13,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读