从Paimon到 Doris ,从Hudi到Iceberg,怎么选?

从Paimon到 Doris ,从Hudi到Iceberg,怎么选?

用户12028736

发布于 2026-02-02 13:07:03

发布于 2026-02-02 13:07:03

"兄弟,我们被坑惨了。"昨晚10点,老王在微信群里发来一条消息,后面跟了一个哭泣的表情。 我点开一看,原来是他们公司花了半年时间搭建的数据湖架构,现在又要推倒重做。原因很简单——选型错误,业务需求和底层技术完全不匹配。 这种情况,在大数据行业太常见了。

一、那些年,我们踩过的技术选型坑

上周参加一个技术沙龙,台下一位架构师问:"我们现在有PB级数据要处理,到底该选Hudi还是Iceberg?"台下瞬间安静了几十个人都竖起耳朵听。

我看了看这位兄弟,突然想起去年帮一家电商公司做技术咨询时的情景。

那家公司的CTO拍着胸脯说:"我们就要最先进的技术!Hudi支持增量更新,Iceberg支持Schema Evolution,都很牛,就选这两个!"

结果呢?

半年后,他们的运维同事每天晚上都要加班到凌晨,处理各种数据一致性问题。

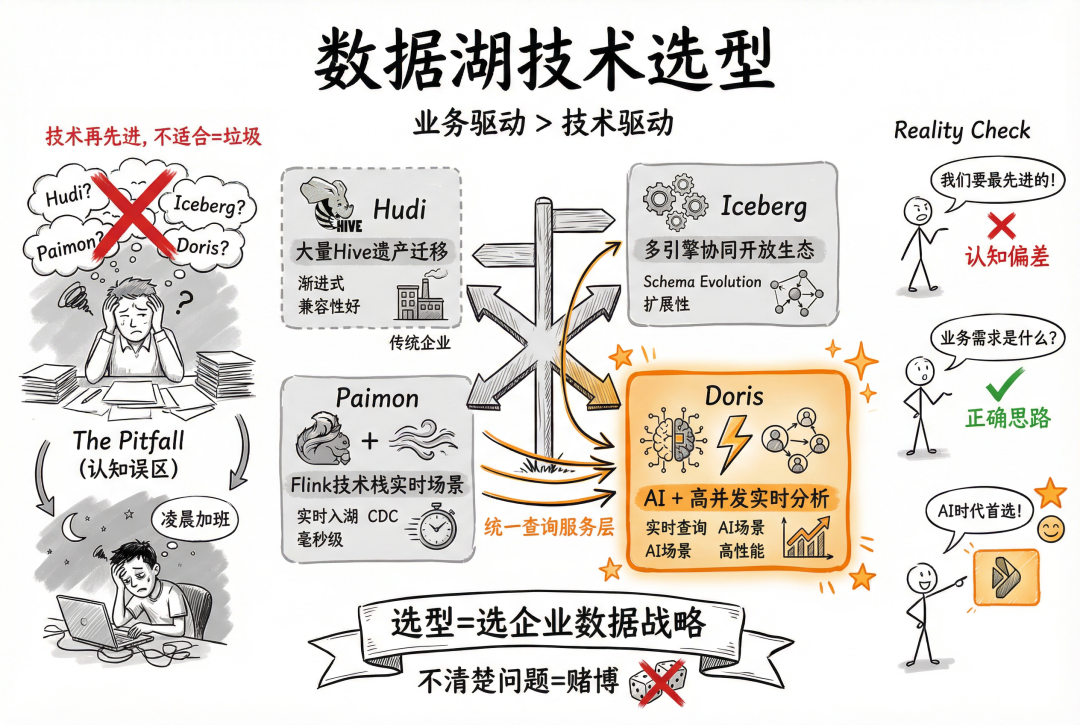

现实很残酷:技术再先进,不适合你的业务场景,就是垃圾。

我见过太多团队,被各种技术名词迷花了眼。

今天听Spark团队说Hudi好,明天听Flink团队说Paimon牛,后天又看到Iceberg的官方博客写得天花乱坠。

结果就是什么技术都想用,最后搞成一个四不像的怪物。

真正的问题不是技术本身,而是你的认知偏差。

很多人以为选数据湖技术就是选工具,其实这是在选企业的数据战略。

Hudi适合什么?适合有大量Hive遗产需要迁移的企业。

Iceberg适合什么?适合需要多引擎协同的开放生态。

Paimon适合什么?适合Flink技术栈的实时场景。

Doris适合什么?适合AI+高并发实时分析需求。

如果你不清楚自己要解决什么问题,技术选型就是赌博。

二、实战案例:三个不同公司的选型之路

让我说三个真实的故事,都是我亲自参与的项目。

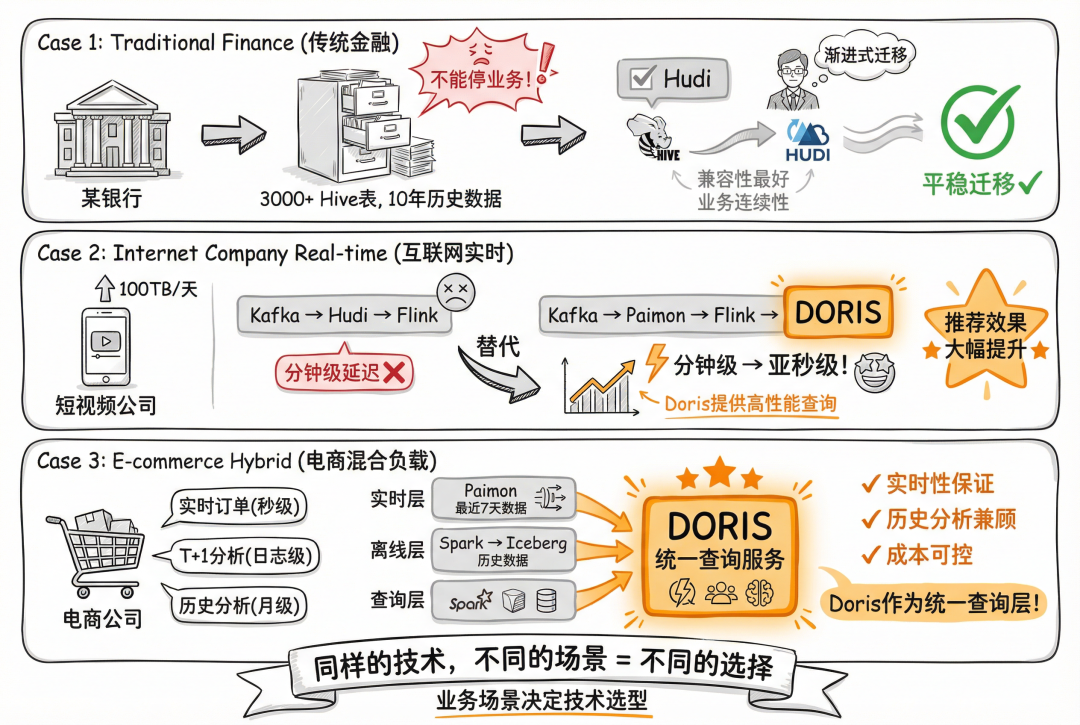

案例一:传统金融公司的渐进式改造

某银行的数据团队有3000多个Hive表,积累了近10年的历史数据。

他们的诉求很简单:不能停业务,渐进式迁移到新架构。

我建议他们用Hudi作为过渡方案。理由很简单:Hudi和Hive兼容性最好,可以逐步替换表格式,同时保持业务连续性。

方案实施后,迁移工作平稳进行。虽然Hudi参数复杂,运维成本高,但这解决了他们最核心的问题——业务不能停。

案例二:互联网公司的实时数仓建设

某短视频公司每天产生100TB数据,需要实时监控用户行为和内容推荐。

技术栈是Kafka+Hudi+Flink+Doris的组合。

我建议他们用Paimon替代Hudi。

原因很简单:Flink原生支持,CDC实时入湖延迟可以控制在毫秒级,而Hudi在Flink场景下性能明显不足。

结果是让他们从原来的分钟级延迟降低到亚秒级,直接提升了推荐系统的效果。

案例三:电商公司的混合负载

某电商公司既要处理实时订单数据(秒级),又要做T+1的数据分析(日志级别),还要支撑历史数据分析(月级别)。

我们设计了分层架构:实时链路用Paimon存储最近7天数据,离线链路用Spark批量写入Iceberg历史数据,然后通过Doris提供统一查询服务。

这个架构看起来复杂,但解决了他们的实际问题:实时性和历史分析兼顾,成本可控。

同样的技术,在不同的业务场景下,完全是不同的选择。

三、选型的本质:业务驱动,不是技术驱动

很多人问我:"老师,现在哪个技术最火?"

我的回答永远是:"业务最匹配的技术最火。"

数据湖技术选型的本质,是业务需求和技术能力的匹配问题。

如果你做实时数仓,首要考虑的是写入延迟和查询性能,Paimon+Doris是黄金组合。

如果你做离线分析,主要考虑的是成本和扩展性,Iceberg+Spark是稳妥选择。

如果你有大量遗产系统,需要平滑迁移,Hudi是你最好的伙伴。

如果你要建设开放生态,支持多引擎协作,Iceberg是唯一选项。

但现实情况是,大多数企业根本不清楚自己的真实需求。

我见过一家公司,明明是离线分析为主,却跟风选了Paimon,结果查询性能一塌糊涂,成本还高得离谱。

也见过一家创业公司,业务还没跑通就急着搭湖仓一体,光是技术栈配置就花了3个月,完全是本末倒置。

技术选型要基于业务发展阶段,不是基于技术趋势。

结语

数据湖技术选型,不是选美比赛,而是找对象。要找合适的,不是找最漂亮的。

每次技术浪潮来临时,总有人被新技术的炫酷特性吸引,忘记了初心。

但真正有经验的技术人明白一个道理:技术的价值在于解决问题,不在于技术本身有多先进。

从Hudi到Iceberg,从Paimon到Doris,每个技术都有它的闪光点和适用场景。关键是你的业务需要什么,你的团队能驾驭什么,你的运维体系能支撑什么。

与其花时间纠结选哪个技术,不如花时间梳理业务需求。

与其追求技术的完美,不如追求解决方案的合适。

技术选型的终极答案,往往不在技术文档里,而在业务场景中。

希望这篇文章能帮你少走一些弯路,多节省一些时间。数据湖建设是一场马拉松,不是百米冲刺。

选对路,走稳每一步,才是王道。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录