同样的USQL作业花费了近4个小时,而之前花费了30分钟,为什么?

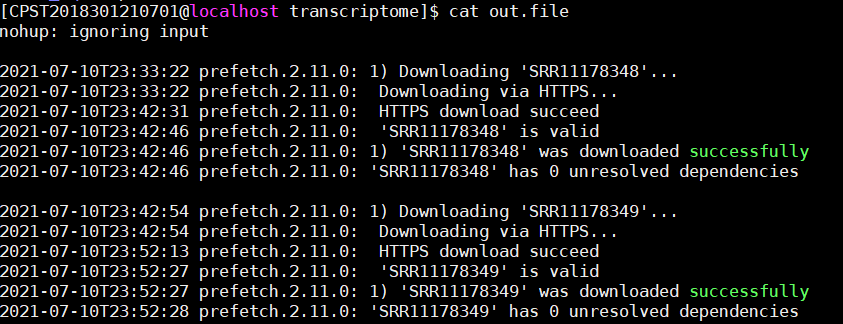

我有一个ADF管道,它运行1 AU的USQL作业。按计划每天一次。正常情况下,完成这项工作大约需要30分钟。但现在我可以看到,作业需要超过3-4个小时才能完成。我可以看到,现在它正在为作业分配更多的顶点。因此,为了比较,我运行相同的旧工作。你可以看到下面的区别。

1)第一个作业- https://cmndatadevdl01.azuredatalakeanalytics.net/jobLink/a3071c07-4b90-4f17-8dab-ba16764d9165它使用5815个顶点和1个AU运行,并在28分钟内完成

2)第二个作业- https://cmndatadevdl01.azuredatalakeanalytics.net/Jobs/07e41502-3785-4f87-97d0-7682d544864b?api-version=2015-10-01-preview我正在用5个AUS运行相同的上述作业,以节省我的时间,它在46分钟内完成。我在运行相同的代码,但它使用了42,330个顶点,为什么?

3)第三个作业https://cmndatadevdl01.azuredatalakeanalytics.net/jobLink/c0037de7-6ba4-4aa5-9938-c7ba17b5edeb这是几乎相同的作业,但输入略有不同,但它需要42173个顶点,在1个AU的情况下在4.4小时内完成

我认为现在Azure数据湖分析帐户有问题。我从几天开始就面临着这个问题。大约一周前,一切都很正常。请帮我解决这个问题

回答 1

Stack Overflow用户

发布于 2018-04-05 19:47:08

很遗憾,我们无法访问您的工作链接。

顶点的数量主要取决于文件的数量、它们的大小,如果使用表,还取决于分布、分区的数量,以及在插入到表中时可能生成的表碎片的数量(经常被忽视但非常重要)。

你能告诉我们更多关于你的数据吗?

- 是否正在查询文件?什么格式(例如,JSON、CSV等)?它们在数量或大小上增长了吗?

- 你在查询表吗?您是否经常插入到它们中?上次重新构建表或表分区是什么时候?

https://stackoverflow.com/questions/49643435

复制