利用DeepSeek-R1构建简单的本地知识库

大家好,我是默语~👋😄 今天带来一篇超级干货、满满实操经验的长文,教你如何利用 DeepSeek-R1 构建简单的本地知识库,以及如何用 DeepSeek 搭配 Kimi 在2分钟内生成32页PPT!🔥💡

利用DeepSeek-R1构建简单的本地知识库

一 简介

初期接触 LLM 即大语言模型,觉得虽然很强大,但是有时候 AI 会一本正经地胡说八道😅,这种大模型的幻觉对于日常使用来说具有很大的误导性,特别是如果我们要用在生成环境下,由于缺少精确性而无法使用。 为什么会造成这种结果呢?简单来说就是模型是为了通用性设计的,缺少相关知识,所以导致回复的结果存在胡说八道的情况。根据香农理论,减少信息熵,就需要引入更多信息📚✨。

从这个角度来说,就有两个途径: 1️⃣ 一是重新利用相关专业知识再次训练加强模型,或进行模型微调; 模型训练的成本是巨大的,微调也需要重新标记数据和大量的计算资源,对于个人来说基本不太现实; 2️⃣ 二是在问 LLM 问题的时候,增加些知识背景,让模型可以根据这些知识背景来回复问题; 后者即是知识库的构建原理了。

有个专门的概念叫 RAG(Retrieval-Augmented Generation),即检索增强生成,是一种结合检索技术和生成模型的技术框架,旨在提升模型生成内容的准确性和相关性💡。 其核心思想是:在生成答案前,先从外部知识库中检索相关信息,再将检索结果与用户输入结合,指导生成模型输出更可靠的回答✅。

二 RAG原理

简单概述,利用已有的文档、内部知识生成向量知识库,在提问的时候结合库的内容一起给大模型,让其回答得更准确,它结合了信息检索和大模型技术🔍🤖;

分步骤来说,首先是 检索阶段:

- 当用户输入一个问题时,系统会从外部数据库或文档中检索相关的信息或文档片段;

然后是 生成阶段:

- 这些检索到的信息会和原始问题一起输入到生成模型中,生成最终的答案。 这样,模型不仅依赖于内部知识,还能利用外部实时或特定的数据📈。

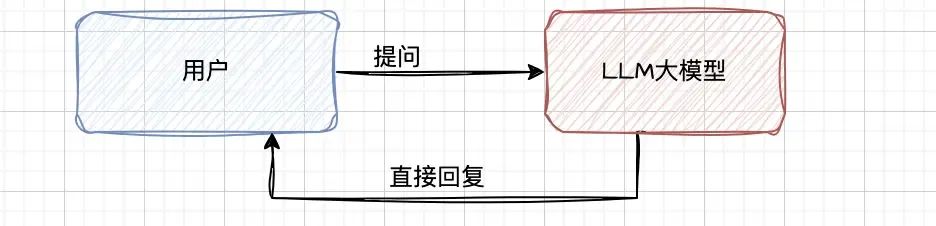

我们日常简单通过 chat 交互方式使用大模型如下图:

图片

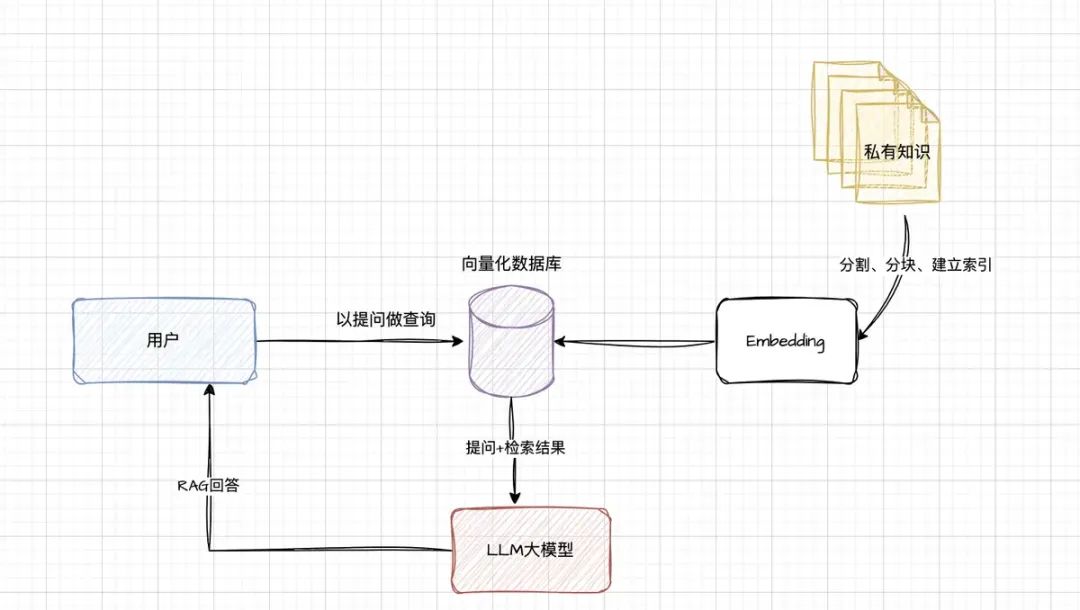

我们搭建了 RAG 后,整体架构如下图:

图片

说明:

- 建立索引: 需要将日常的业务知识,以文件形式分成较短的块(chunk),然后进行编码,向量化存入到向量库中; nomic-embed-text-v1 模型就是做这个事情的。

- 检索向量库: 根据用户的提问,到向量库中进行向量匹配,检索出相似的 chunk,作为提问的上下文;

- 生成回复: 将用户的提问内容和检索的块结合发送给大模型,大模型结合两者进行问题的回复;

这样做有什么好处呢?

- 由于日常的业务知识是保存到本地的,所以减少信息泄露的风险🔒;

- 由于提问结合了业务知识,所以减少了模型的幻觉,即减少了模型的胡说八道😇;

- 模型的回复结合了业务知识和实时知识,所以实时性更佳⏱️;

- 不用重新训练模型,微调模型降低了成本💸。

三 实践

需要安装以下工具:

- Ollama: 用于下载和管理模型,前面文章介绍过;

- DeepSeek-R1: 我们本次要使用的 LLM 模型,前面文章也介绍过;

- Nomic-Embed-Text 向量模型: 用于将文本库进行切分、编码,转换进入向量库;

- AnythingLLM: 开源 AI 私有化应用构建平台,即将多个模型搭配起来,共同构建一个私有化应用; 利用强大的内置工具和功能快速运行本地 LLM,无需复杂的设置。 Ollama 和 DeepSeek-R1 模型前面已经安装过了,就不再赘述,下面安装另外两个工具😉。

3.1 Nomic-Embed-Text 模型安装

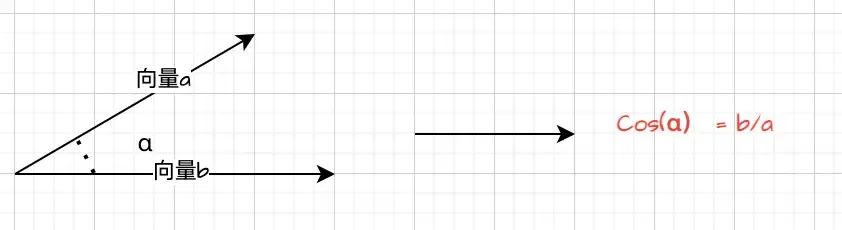

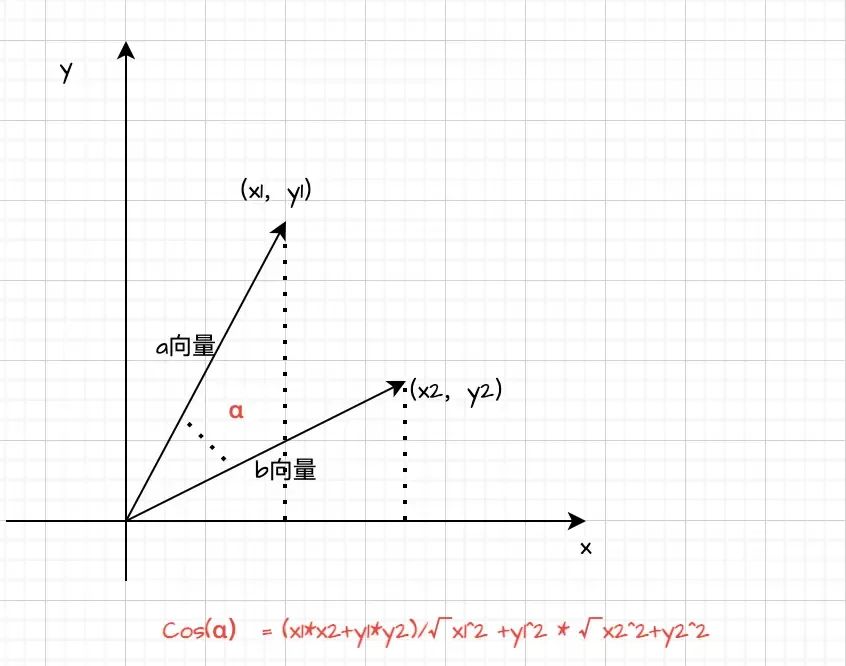

简单介绍下,Nomic-Embed-Text 模型是一个强大的嵌入式文本处理工具,将我们的业务知识(专业点的叫法语料库)转成高纬度的向量空间中的点,以便后续进行相似度计算、分类、聚类、检索等🔢。 听起来这个好像很高级,如果简单来看的话,其实底层原理也简单,文本相似度可以通过两个高纬度向量的余弦值大小来判断的,余弦值越大,两个高纬度向量靠得越近,相关性越大,反之亦然,当然也有复杂的算法📐。

图片

图片

余弦值计算

通过 pull 命令直接安装,大小为 274MB,还是比较小的:

ollama pull nomic-embed-text然后通过 ollama list 查询:

mac@MacdeMacBook-Pro models % ollama list

NAME ID SIZE MODIFIED

nomic-embed-text:latest 0a109f422b47 274 MB 17 minutes ago

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 4 days ago网上找一个使用的例子,大家可以直观地体会下:

from transformers import AutoTokenizer, AutoModel

import torch

# 加载模型和分词器

tokenizer = AutoTokenizer.from_pretrained("nomic-embed-text-v1")

model = AutoModel.from_pretrained("nomic-embed-text-v1")

# 输入文本

text1 = "今天天气好!"

text2 = "今天的天气真是好啊!"

# 将文本转换为模型输入格式

encoding = tokenizer(text1, text2, return_tensors="pt")

# 获取文本嵌入

with torch.no_grad():

outputs = model(encoding)

# 计算文本嵌入的余弦相似度

cosine_similarity = torch.nn.functional.cosine_similarity(outputs.last_hidden_state[0], outputs.last_hidden_state[1])

print("文本相似度:", cosine_similarity.item())3.2 AnythingLLM安装

如它官网图 https://anythingllm.com/desktop 所示,是一个强大而灵活的平台,通过它可以连接多个 LLM 模型,构建本地私有的 LLM 应用,配置界面简单直观🖥️✨。

图片

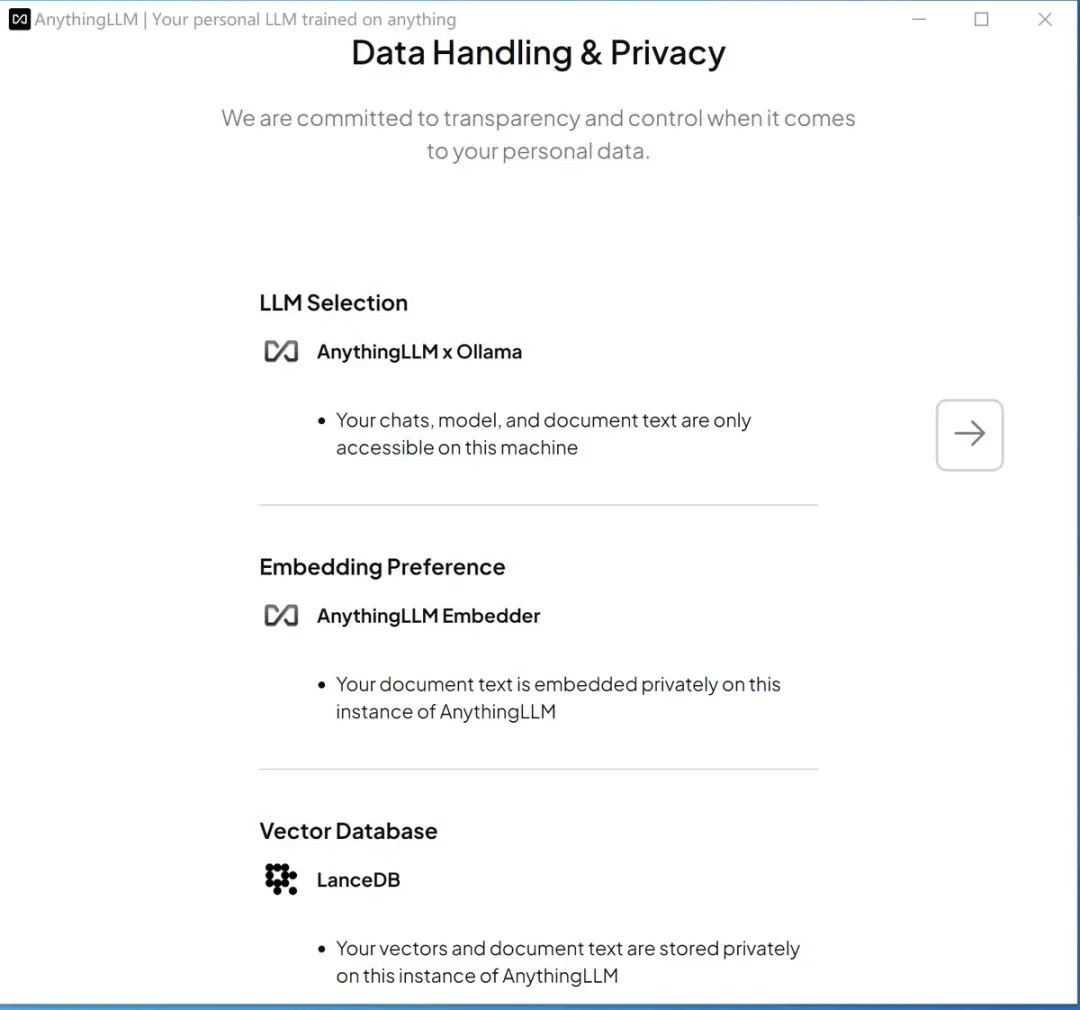

非常可惜,我 macOS 的版本低,运行 AnythingLLM 报错,找了不少办法还是不行,所以在虚拟机(Windows 下)安装,运行界面如下图:

图片

如上图可以看到,这个架构默认需要一个 chat 模型,需要 embedder 模型和一个向量数据库:LanceDB,用来保存私有化的数据💾;

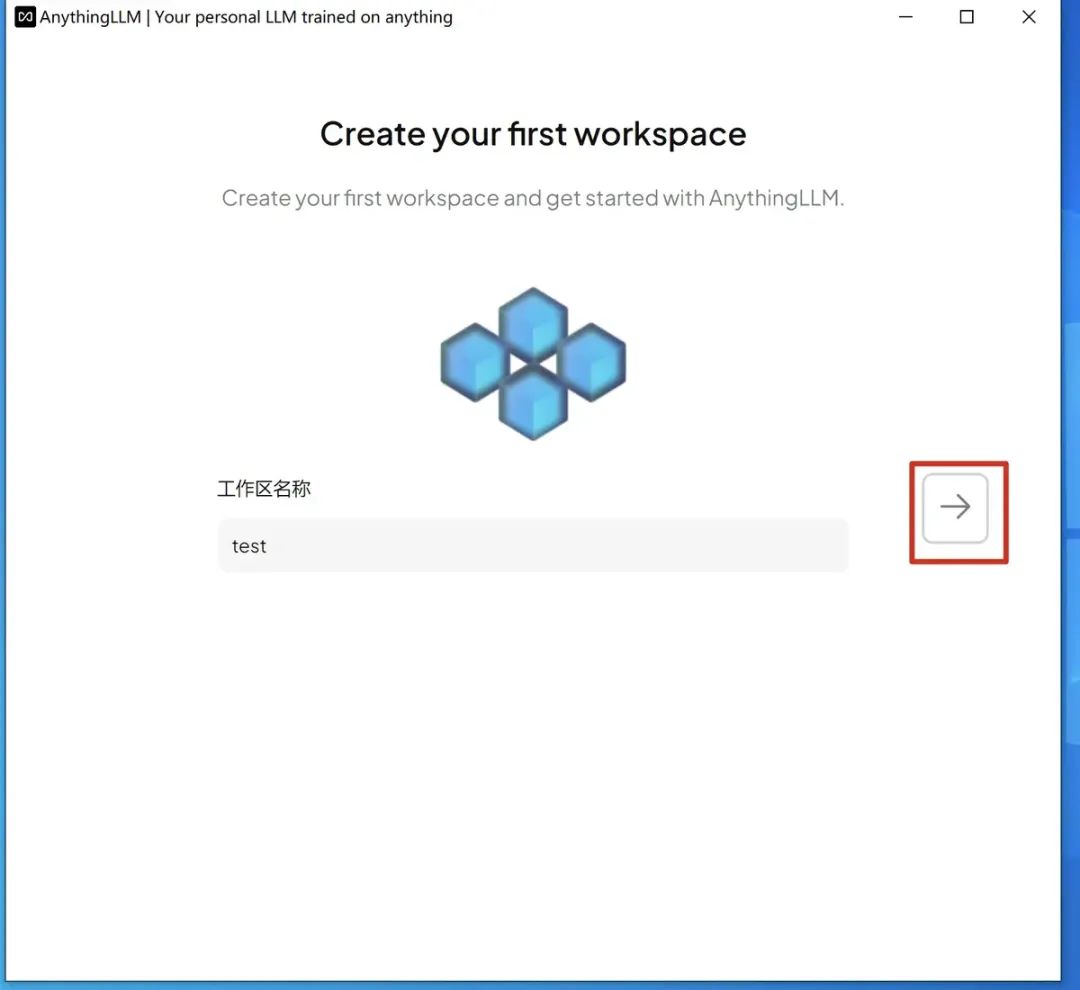

按右边的向右箭头,新建个工作区:

图片

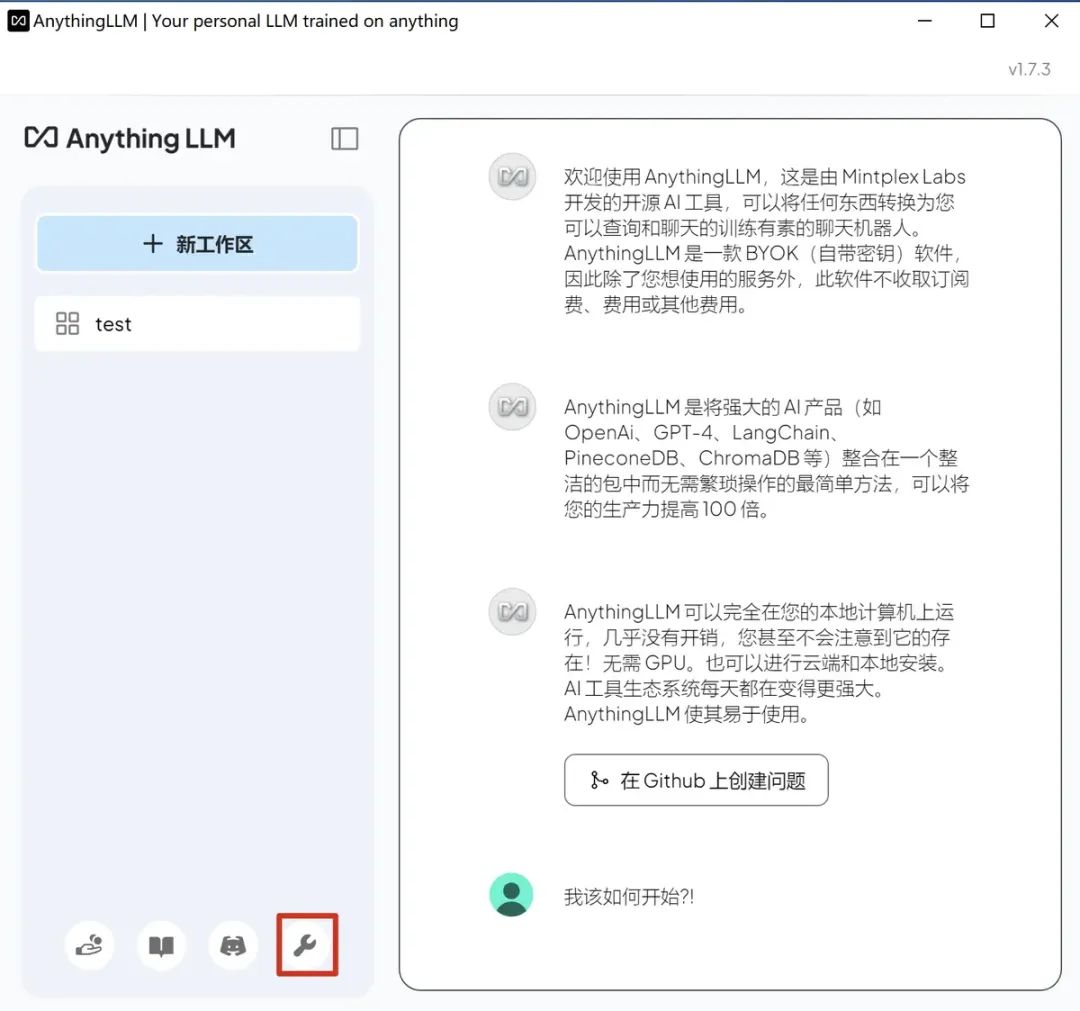

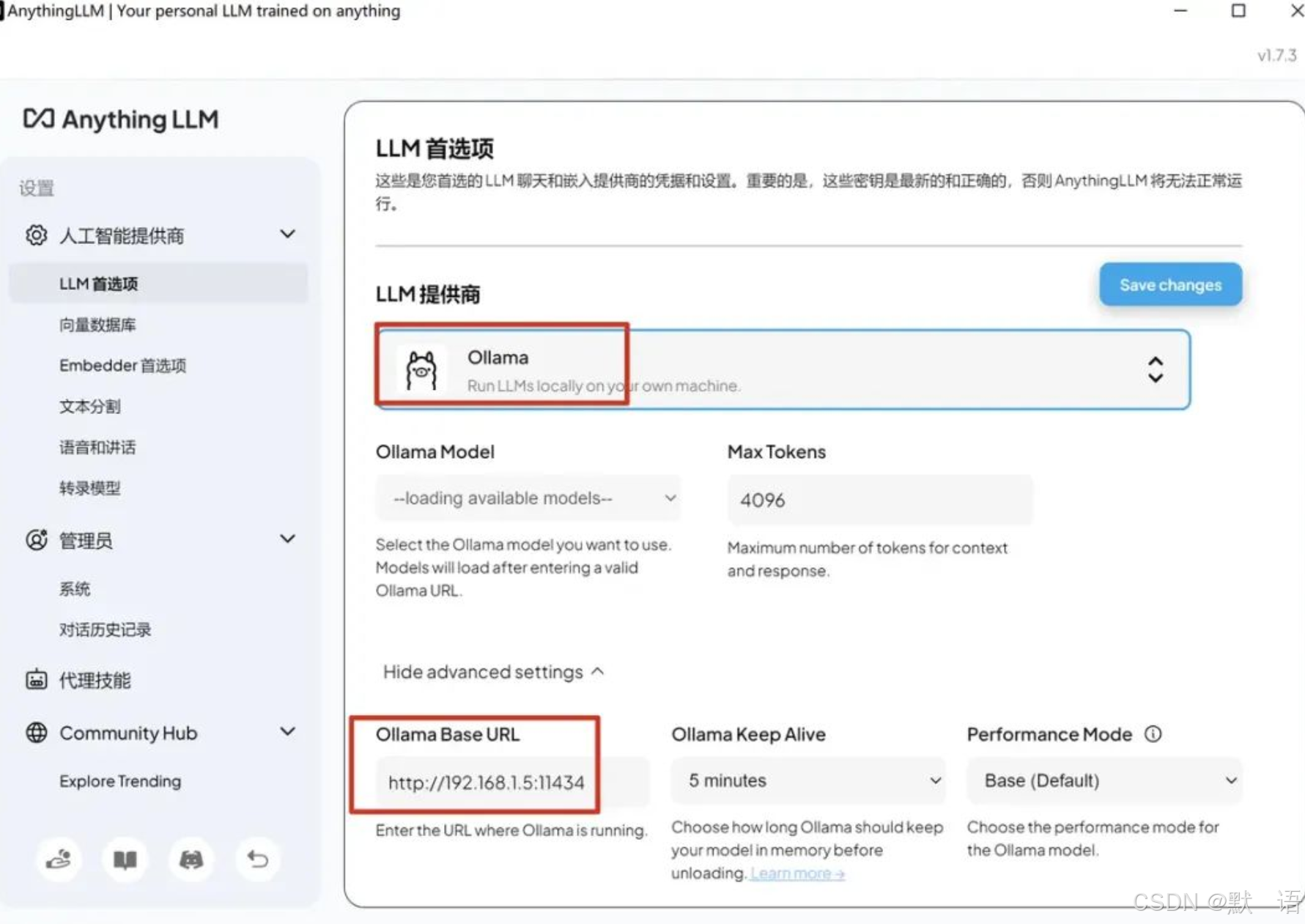

接着进行模型配置:

图片

选择 LLM 模型提供商,配置下 URL,如下图:

在这里插入图片描述

点击右上角的 Save changes。

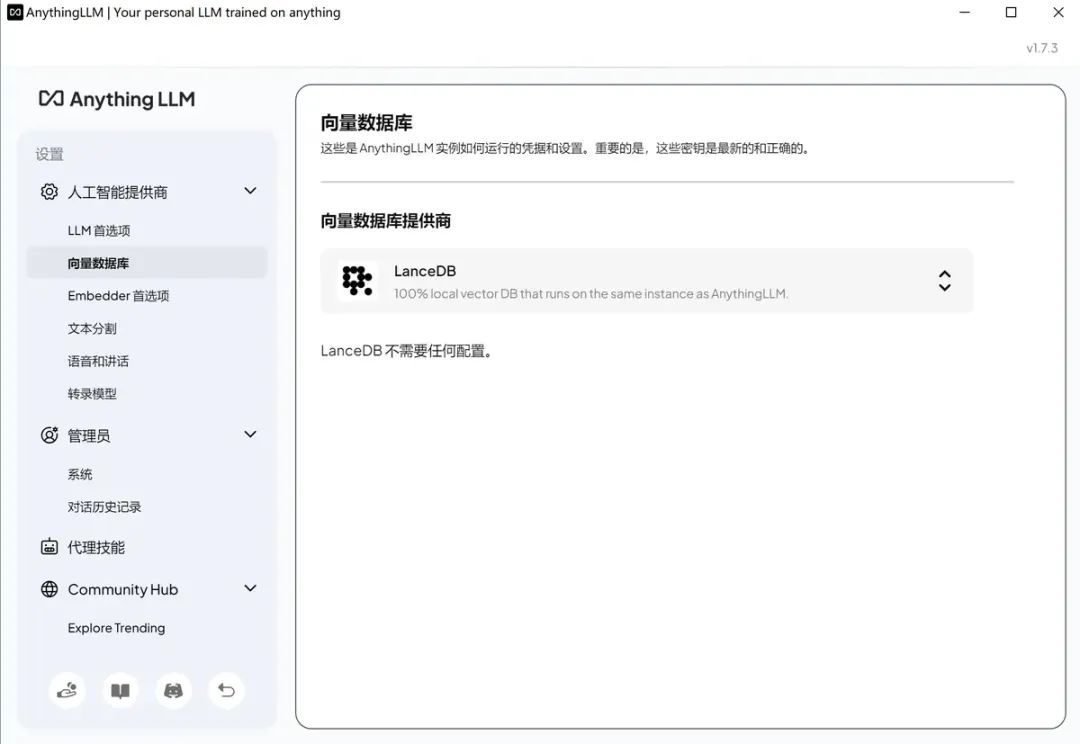

向量数据库无需配置,默认即可:

图片

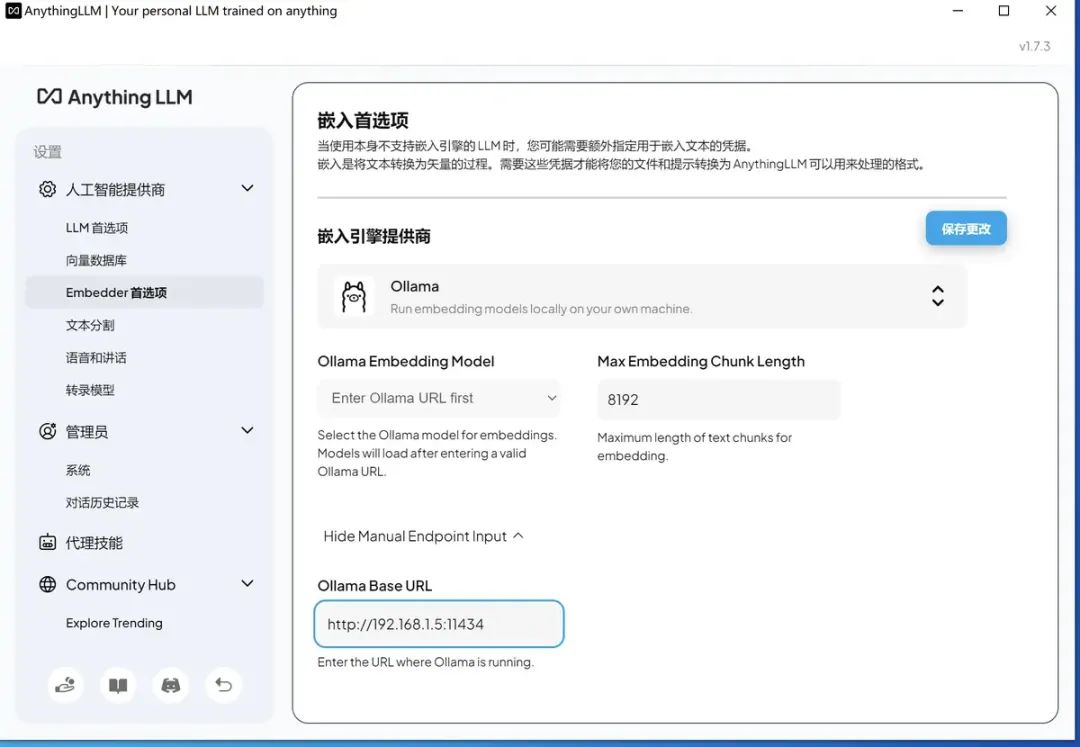

embedder 模型,可以用默认的,或通过 Ollama 供应商提供的,我先用 Ollama 试试效果:

图片

别忘记点击修改🔧。这里面有个坑,虽然 11434 端口开了,但是默认只能用 127.0.0.1 访问,如果绑定所有 IP,则在 mac 下需要配置:

mac@MacdeMacBook-Pro Homebrew % sudo sh -c 'echo "export OLLAMA_HOST=0.0.0.0:11434">>/etc/profile'launchctl setenv OLLAMA_HOST "0.0.0.0:11434" 返回刚才新建的工作区,点击后进入聊天界面就可以上传语料进行交互问答了:

至此,个人知识库终于创建完毕了 个人知识库的问答

四 总结

我们通过搭建本地模型,配合 Embedder 和向量数据库,可以直接构建一个隐私性更好、实时性更高的个人知识库 DAG📊。 工作中除了需要知识库,更需要 BPA,即业务自动化,利用 LLM 模型来提高自动化水平,这种系统更实用。 下一步的目标是逐步构建 BPA 系统,希望大家能持续关注~🙌

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-02-17,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录