将AVAudioEngine的输出重定向到AUv3中的呈现块

将AVAudioEngine的输出重定向到AUv3中的呈现块

提问于 2019-09-16 07:47:53

我目前有一个基于Swift编写的AVAudioEngine的Xcode项目。

引擎的顶部是一个AVAudioPlayerNode,用于调度一些LPCM音频缓冲区。

为了让AUv3处理音频,它需要覆盖以下属性(来自这里的信息)

- 重写

inputBussesgetter方法以返回应用程序扩展的音频输入连接点。 - 重写

outputBussesgetter方法以返回应用程序扩展的音频输出连接点。 - 重写

internalRenderBlockgetter方法以返回实现app扩展的音频呈现循环的块。 还必须覆盖宿主应用程序在开始呈现音频之前调用的allocateRenderResourcesAndReturnError:方法,并重写宿主应用程序在呈现音频之后调用的deallocateRenderResources方法。

在每个覆盖中,必须调用AUAudioUnit超类实现。

给定一个工作的AVAudioEngine,在何处或如何将inputbusses、outputbusses和缓冲区连接到AUv3中的internalRenderBlock?

我有一个工作的原型AUv3,它可以加载到像GarageBand这样的主机中。

我要做的是将音频缓冲区从AVAudioEngine传递到AUv3的internalRenderBlock,以便完成从AUv3到主机的音频管道。

回答 1

Stack Overflow用户

发布于 2019-09-17 09:33:08

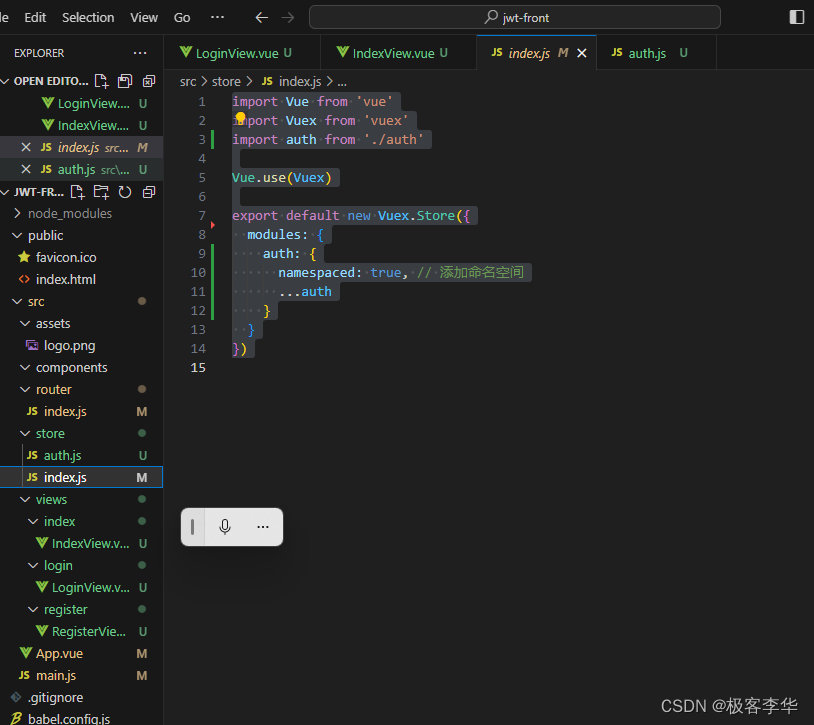

这里有一些在AUv3 internalRenderBlock中生成示例数据的示例代码:

它是在目标C的C子集中编写的,因为2017年WWDC关于音频单元的会议说在实时音频上下文中不使用Swift。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/57960383

复制相关文章

相似问题

![[译] 依赖注入在多模块工程中的应用](https://ask.qcloudimg.com/http-save/yehe-2267234/1281d253e73bd87ec24d83bdbeffba9b.png)