43. Ray 在 vLLM 中的角色:分布式推理的强力引擎

43. Ray 在 vLLM 中的角色:分布式推理的强力引擎

安全风信子

发布于 2026-01-30 13:12:55

发布于 2026-01-30 13:12:55

作者:HOS(安全风信子) 日期:2026-01-19 来源平台:GitHub 摘要: 本文深入剖析Ray在vLLM框架中的核心角色,作为分布式推理的强力引擎,Ray为vLLM提供了高效的Actor通信、智能资源调度、故障容错和动态扩缩容能力。通过分析Ray与vLLM的深度集成机制、Ray Actor的实现细节、资源感知调度策略以及故障恢复机制,结合真实源码示例和性能数据,揭示Ray如何赋能vLLM实现大规模分布式推理。文章还探讨了Ray生态的扩展应用、性能优化技巧以及与其他分布式框架的深度对比,为推理工程师提供全面的Ray在vLLM中应用的理解与实践指南。

1. 背景动机与当前热点

1.1 为什么Ray在vLLM中值得重点关注?

在vLLM框架中,Ray扮演着至关重要的角色,它是实现分布式推理的核心引擎,直接影响系统的可扩展性、性能和可靠性:

- 分布式通信:Ray为vLLM提供了高效的Actor通信机制,支持跨节点、跨GPU的低延迟通信。

- 资源管理:Ray的资源感知调度器能够智能分配GPU、CPU等硬件资源,提高资源利用率。

- 故障容错:Ray的故障检测和恢复机制确保vLLM在节点故障时能够自动恢复,提高系统可靠性。

- 动态扩缩容:基于Ray的动态扩缩容能力,vLLM能够根据负载情况自动调整Worker数量。

- 生态集成:Ray丰富的生态系统为vLLM提供了与其他工具和框架的无缝集成能力。

1.2 当前Ray在分布式推理中的应用热点

随着大模型推理需求的不断增长,Ray在分布式推理中的应用越来越广泛:

- 大规模模型推理:Ray支持TB级模型的分布式推理,满足超大模型的推理需求。

- 实时推理服务:Ray的低延迟通信机制支持实时推理服务,满足高并发场景需求。

- 混合部署:Ray支持CPU、GPU、边缘设备等混合部署,实现边缘云协同推理。

- 动态资源分配:Ray的资源感知调度器能够根据任务需求动态分配资源,提高资源利用率。

- 云原生支持:Ray原生支持Kubernetes等云原生环境,简化分布式部署流程。

1.3 Ray与vLLM的结合优势

Ray与vLLM的结合带来了多项优势:

- 高性能:Ray的高效通信机制和资源调度提高了vLLM的推理性能。

- 可扩展性:Ray支持vLLM从单节点到大规模分布式的平滑扩展。

- 易用性:Ray简化了vLLM的分布式部署和管理,降低了开发成本。

- 可靠性:Ray的故障容错机制提高了vLLM的系统可靠性。

- 灵活性:Ray支持多种部署模式,满足不同场景需求。

2. 核心更新亮点与新要素

2.1 Ray Actor通信优化

vLLM 2026版本中,Ray Actor通信机制得到了进一步优化:

- 共享内存通信:同一节点内的Actor通过共享内存通信,减少数据拷贝开销。

- 异步通信支持:采用异步通信模式,提高通信效率,减少等待时间。

- 通信压缩:对传输的数据进行压缩,减少网络带宽占用。

- RDMA支持:支持RDMA(远程直接内存访问),进一步降低通信延迟。

- 智能路由:根据网络拓扑和负载情况,智能选择通信路径,提高通信速度。

2.2 资源感知调度增强

Ray的资源感知调度器在vLLM中得到了增强:

- GPU内存感知:根据GPU内存使用情况,智能分配任务,避免OOM错误。

- 动态资源预留:根据任务需求,动态预留资源,提高资源利用率。

- 多级调度:采用全局调度和本地调度相结合的多级调度策略,提高调度效率。

- 优先级调度:支持基于优先级的任务调度,保证关键任务的响应时间。

- 负载均衡:智能平衡各个节点的负载,避免热点节点。

2.3 故障容错机制升级

Ray的故障容错机制在vLLM中得到了升级:

- 快速故障检测:采用心跳机制和健康检查相结合的方式,快速检测故障节点。

- 自动故障恢复:当节点故障时,自动将任务迁移到其他健康节点,确保任务不丢失。

- 状态持久化:支持任务状态的持久化,便于故障恢复时恢复任务状态。

- 优雅降级:在资源不足时,支持优雅降级,保证核心功能可用。

- 多级容错:采用节点级、Actor级、任务级的多级容错机制,提高系统可靠性。

2.4 动态扩缩容优化

基于Ray的动态扩缩容能力在vLLM中得到了优化:

- 智能扩缩容策略:根据负载情况、资源使用情况和任务类型,智能调整Worker数量。

- 快速扩容:采用预热机制和并行加载技术,减少扩容时的冷启动延迟。

- 平滑缩容:在缩容时,确保正在执行的任务完成后再关闭Worker,避免任务中断。

- 成本优化:根据资源使用情况,动态调整资源分配,降低推理成本。

- 预测性扩缩容:根据历史负载模式,预测未来负载,提前调整Worker数量。

2.5 Ray生态深度集成

vLLM与Ray生态的深度集成带来了更多功能:

- Ray Tune集成:支持使用Ray Tune进行超参数调优,优化模型性能。

- Ray Serve集成:支持使用Ray Serve部署vLLM模型,简化模型服务部署。

- Ray Data集成:支持使用Ray Data处理大规模数据集,提高数据处理效率。

- Ray RLlib集成:支持使用Ray RLlib进行强化学习,优化模型推理策略。

- Ray Workflows集成:支持使用Ray Workflows构建复杂的推理流水线。

3. 技术深度拆解与实现分析

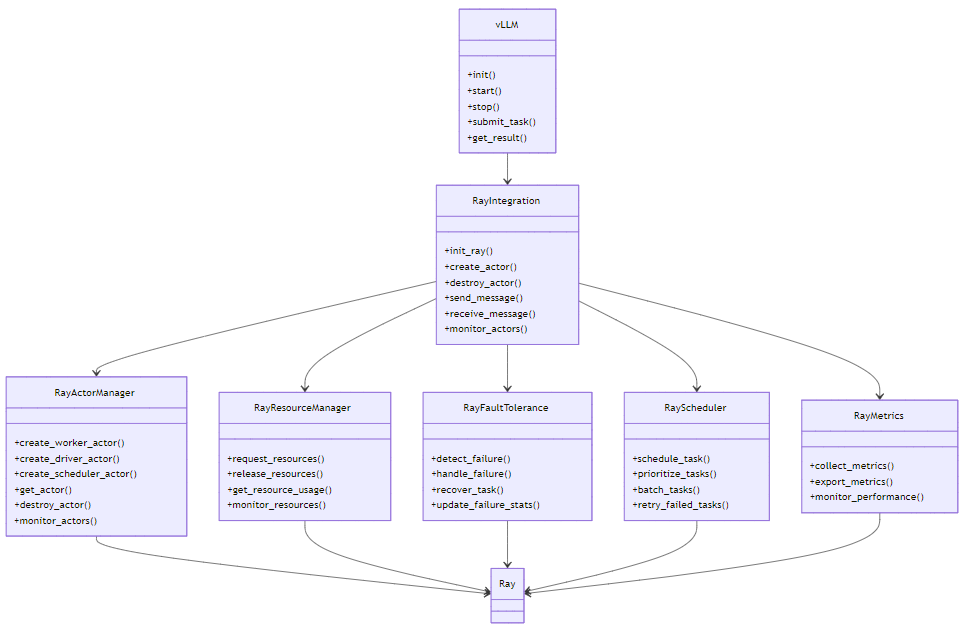

3.1 Ray在vLLM中的架构设计

vLLM中Ray的架构设计采用了分层结构,确保灵活性和扩展性:

架构解析:

- RayIntegration:vLLM与Ray的集成层,负责初始化Ray、创建Actor、管理通信等。

- RayActorManager:管理vLLM中的Ray Actor,包括Worker Actor、Driver Actor、Scheduler Actor等。

- RayResourceManager:管理Ray资源,包括资源请求、释放、监控等。

- RayFaultTolerance:处理Ray Actor的故障,包括故障检测、恢复等。

- RayScheduler:基于Ray的任务调度器,负责任务的分配和调度。

- RayMetrics:收集和导出Ray相关的指标,用于监控和性能分析。

3.2 Ray Actor的实现

在vLLM中,Ray Actor是实现分布式推理的核心组件,负责具体的推理任务执行:

# vllm/ray_integration/actor.py

import ray

from typing import Dict, Any, Optional

@ray.remote

class vLLMActor:

def __init__(self, actor_id: str, config: Dict[str, Any]):

self.actor_id = actor_id

self.config = config

self.model = None

self.tokenizer = None

self.is_initialized = False

self.heartbeat_time = None

def initialize(self):

"""初始化Actor,加载模型"""

if self.is_initialized:

return True

try:

# 加载模型

from vllm.model_loader import ModelLoader

model_loader = ModelLoader(self.config)

loaded = model_loader.load()

self.model = loaded['model']

self.tokenizer = loaded['tokenizer']

# 设置模型为评估模式

self.model.eval()

# 预热模型

self._warmup_model()

self.is_initialized = True

self.heartbeat_time = ray.get_runtime_context().get_node_id()

return True

except Exception as e:

print(f"Actor {self.actor_id} initialization failed: {e}")

return False

def _warmup_model(self):

"""预热模型"""

import torch

# 生成一个简单的输入

input_ids = torch.tensor([[1, 2, 3, 4, 5]], device=self.model.device)

# 执行一次前向传播

with torch.no_grad():

self.model(input_ids)

def execute_task(self, task: Dict[str, Any]) -> Dict[str, Any]:

"""执行推理任务"""

if not self.is_initialized:

self.initialize()

# 更新心跳时间

self.heartbeat_time = ray.get_runtime_context().get_node_id()

# 解析任务

input_ids = task.get('input_ids')

max_new_tokens = task.get('max_new_tokens', 100)

temperature = task.get('temperature', 0.7)

top_p = task.get('top_p', 0.95)

# 转换为张量

import torch

input_ids = torch.tensor(input_ids, device=self.model.device)

# 执行推理

with torch.no_grad():

outputs = self.model.generate(

input_ids=input_ids,

max_new_tokens=max_new_tokens,

temperature=temperature,

top_p=top_p

)

# 解码结果

generated_text = self.tokenizer.decode(

outputs[0],

skip_special_tokens=True

)

# 构造结果

result = {

'generated_text': generated_text,

'input_ids': input_ids.tolist(),

'output_ids': outputs[0].tolist(),

'actor_id': self.actor_id

}

return result

def send_heartbeat(self) -> Dict[str, Any]:

"""发送心跳"""

return {

'actor_id': self.actor_id,

'timestamp': ray.get_runtime_context().get_node_id(),

'is_initialized': self.is_initialized,

'heartbeat_time': self.heartbeat_time

}

def get_resource_usage(self) -> Dict[str, Any]:

"""获取资源使用情况"""

import psutil

import torch

# 获取CPU使用情况

cpu_usage = psutil.cpu_percent(interval=0.1)

# 获取内存使用情况

memory = psutil.virtual_memory()

memory_used = memory.used / (1024 ** 3) # GB

memory_total = memory.total / (1024 ** 3) # GB

# 获取GPU使用情况

gpu_usage = 0

gpu_memory_used = 0

gpu_memory_total = 0

if torch.cuda.is_available():

gpu_usage = torch.cuda.utilization()

gpu_memory_used = torch.cuda.memory_allocated() / (1024 ** 3) # GB

gpu_memory_total = torch.cuda.get_device_properties(0).total_memory / (1024 ** 3) # GB

return {

'cpu_usage': cpu_usage,

'memory_used': memory_used,

'memory_total': memory_total,

'gpu_usage': gpu_usage,

'gpu_memory_used': gpu_memory_used,

'gpu_memory_total': gpu_memory_total

}

def shutdown(self):

"""关闭Actor"""

# 释放模型资源

if self.model:

del self.model

self.model = None

if self.tokenizer:

del self.tokenizer

self.tokenizer = None

# 释放GPU内存

import torch

if torch.cuda.is_available():

torch.cuda.empty_cache()

self.is_initialized = False

print(f"Actor {self.actor_id} shutdown")代码解析:

- Actor初始化:负责加载模型、预热模型,确保Actor就绪。

- 任务执行:执行具体的推理任务,包括输入处理、模型推理和结果解码。

- 心跳机制:定期发送心跳,向Driver报告Actor状态。

- 资源监控:监控CPU、内存、GPU等资源使用情况。

- 优雅关闭:关闭Actor时,释放模型资源和GPU内存。

3.3 Ray资源管理实现

vLLM中的Ray资源管理模块负责资源的请求、分配和监控:

# vllm/ray_integration/resource_manager.py

import ray

from typing import Dict, List, Any, Optional

import time

class RayResourceManager:

def __init__(self, config: Dict[str, Any]):

self.config = config

self.resource_requests = {} # request_id -> resource_request

self.allocated_resources = {} # actor_id -> allocated_resources

self.resource_usage = {} # node_id -> resource_usage

self.resource_monitor_thread = None

self.is_running = False

def start(self):

"""启动资源管理器"""

self.is_running = True

# 启动资源监控线程

import threading

self.resource_monitor_thread = threading.Thread(target=self._monitor_resources)

self.resource_monitor_thread.daemon = True

self.resource_monitor_thread.start()

def stop(self):

"""停止资源管理器"""

self.is_running = False

if self.resource_monitor_thread:

self.resource_monitor_thread.join()

def request_resources(self, resource_request: Dict[str, Any]) -> str:

"""请求资源"""

# 生成请求ID

request_id = f"req_{len(self.resource_requests) + 1}"

self.resource_requests[request_id] = resource_request

# 向Ray请求资源

ray.get(ray.actor.exit_on_resource_starvation.remote(

resources=resource_request.get('resources', {})

))

return request_id

def release_resources(self, request_id: str):

"""释放资源"""

if request_id in self.resource_requests:

del self.resource_requests[request_id]

def allocate_resources(self, actor_id: str, resources: Dict[str, Any]):

"""分配资源给Actor"""

self.allocated_resources[actor_id] = resources

def free_resources(self, actor_id: str):

"""释放Actor的资源"""

if actor_id in self.allocated_resources:

del self.allocated_resources[actor_id]

def get_resource_usage(self, node_id: Optional[str] = None) -> Dict[str, Any]:

"""获取资源使用情况"""

if node_id:

return self.resource_usage.get(node_id, {})

return self.resource_usage

def _monitor_resources(self):

"""监控资源使用情况"""

while self.is_running:

time.sleep(self.config.get('resource_monitor_interval', 5.0))

self._update_resource_usage()

def _update_resource_usage(self):

"""更新资源使用情况"""

# 获取所有节点

nodes = ray.nodes()

for node in nodes:

node_id = node['NodeID']

resources = node['Resources']

# 解析资源使用情况

cpu_used = 0

cpu_total = 0

gpu_used = 0

gpu_total = 0

memory_used = 0

memory_total = 0

for resource_name, value in resources.items():

if resource_name.startswith('CPU'):

cpu_total += value

elif resource_name.startswith('GPU'):

gpu_total += value

elif resource_name.startswith('memory'):

memory_total += value

# 获取已分配的资源

allocated_cpu = sum(

r.get('CPU', 0) for r in self.allocated_resources.values()

)

allocated_gpu = sum(

r.get('GPU', 0) for r in self.allocated_resources.values()

)

# 计算资源使用百分比

cpu_usage = (allocated_cpu / cpu_total) * 100 if cpu_total > 0 else 0

gpu_usage = (allocated_gpu / gpu_total) * 100 if gpu_total > 0 else 0

self.resource_usage[node_id] = {

'node_id': node_id,

'cpu_usage': cpu_usage,

'cpu_total': cpu_total,

'cpu_allocated': allocated_cpu,

'gpu_usage': gpu_usage,

'gpu_total': gpu_total,

'gpu_allocated': allocated_gpu,

'memory_used': memory_used,

'memory_total': memory_total,

'timestamp': time.time()

}

def get_available_resources(self) -> Dict[str, Any]:

"""获取可用资源"""

# 获取Ray可用资源

available = ray.available_resources()

# 过滤掉内部资源

filtered = {}

for resource_name, value in available.items():

if not resource_name.startswith('object_store') and not resource_name.startswith('node:'):

filtered[resource_name] = value

return filtered

def is_resource_available(self, resources: Dict[str, Any]) -> bool:

"""检查资源是否可用"""

available = self.get_available_resources()

# 检查每个资源是否可用

for resource_name, required in resources.items():

if resource_name not in available or available[resource_name] < required:

return False

return True代码解析:

- 资源请求与释放:负责向Ray请求资源,并在使用完毕后释放资源。

- 资源分配:将资源分配给具体的Actor,并在Actor关闭时释放资源。

- 资源监控:定期监控各个节点的资源使用情况,包括CPU、GPU、内存等。

- 资源可用性检查:检查是否有足够的资源满足新的请求。

- 资源使用统计:统计已分配的资源和可用资源,为调度器提供决策依据。

3.4 Ray调度器实现

vLLM中的Ray调度器负责任务的分配和调度:

# vllm/ray_integration/scheduler.py

from typing import Dict, List, Any, Optional

import time

import threading

class RayScheduler:

def __init__(self, config: Dict[str, Any]):

self.config = config

self.tasks = [] # 待执行的任务列表

self.running_tasks = {} # task_id -> (actor_id, future)

self.task_lock = threading.Lock()

self.is_running = False

self.schedule_thread = None

def start(self):

"""启动调度器"""

self.is_running = True

# 启动调度线程

self.schedule_thread = threading.Thread(target=self._schedule_loop)

self.schedule_thread.daemon = True

self.schedule_thread.start()

def stop(self):

"""停止调度器"""

self.is_running = False

if self.schedule_thread:

self.schedule_thread.join()

def submit_task(self, task: Dict[str, Any]) -> str:

"""提交任务"""

with self.task_lock:

# 生成任务ID

task_id = f"task_{len(self.tasks) + len(self.running_tasks) + 1}"

task['task_id'] = task_id

self.tasks.append(task)

return task_id

def _schedule_loop(self):

"""调度循环"""

while self.is_running:

time.sleep(self.config.get('schedule_interval', 0.1))

self._schedule_tasks()

def _schedule_tasks(self):

"""调度任务"""

from vllm.ray_integration.actor_manager import RayActorManager

from vllm.ray_integration.resource_manager import RayResourceManager

with self.task_lock:

if not self.tasks:

return

# 获取Actor管理器和资源管理器实例

actor_manager = RayActorManager.get_instance()

resource_manager = RayResourceManager.get_instance()

if not actor_manager or not resource_manager:

return

# 获取可用Actor

available_actors = actor_manager.get_available_actors()

if not available_actors:

# 没有可用Actor,尝试创建新Actor

if resource_manager.is_resource_available(

self.config.get('actor_resources', {'CPU': 1, 'GPU': 0})

):

actor_manager.create_worker_actor()

return

# 批处理优化:将相似任务合并

batched_tasks = self._batch_tasks(self.tasks)

# 调度任务

for batch in batched_tasks:

# 选择合适的Actor

actor_id = self._select_actor(batch, available_actors, resource_manager)

if not actor_id:

continue

# 分配任务

self._assign_task(batch, actor_id, actor_manager)

def _batch_tasks(self, tasks: List[Dict[str, Any]]) -> List[List[Dict[str, Any]]]:

"""批处理任务"""

# 简化实现:将所有任务合并为一个批次

# 实际实现会根据任务类型、模型大小等因素进行智能批处理

batch_size = self.config.get('batch_size', 32)

return [tasks[i:i+batch_size] for i in range(0, len(tasks), batch_size)]

def _select_actor(self, batch: List[Dict[str, Any]], actors: List[str],

resource_manager: RayResourceManager) -> Optional[str]:

"""选择合适的Actor"""

# 简化实现:选择资源使用最少的Actor

if not actors:

return None

# 获取每个Actor的资源使用情况

actor_resources = {}

for actor_id in actors:

usage = resource_manager.get_resource_usage(actor_id)

actor_resources[actor_id] = usage

# 选择资源使用最少的Actor

return min(

actors,

key=lambda a: actor_resources[a].get('cpu_usage', 0) + \

actor_resources[a].get('gpu_usage', 0)

)

def _assign_task(self, batch: List[Dict[str, Any]], actor_id: str,

actor_manager: RayActorManager):

"""分配任务给Actor"""

# 获取Actor

actor = actor_manager.get_actor(actor_id)

if not actor:

return

# 提交任务到Actor

def task_done(future, batch):

"""任务完成回调"""

try:

results = future.result()

# 处理结果

for task, result in zip(batch, results):

self._handle_task_result(task['task_id'], result)

except Exception as e:

print(f"Task execution failed: {e}")

# 重试任务

for task in batch:

with self.task_lock:

self.tasks.append(task)

# 异步执行任务

future = actor.execute_task.remote(batch)

future.add_done_callback(lambda f: task_done(f, batch))

# 更新运行中任务列表

for task in batch:

self.running_tasks[task['task_id']] = (actor_id, future)

# 从待执行任务列表中移除

with self.task_lock:

if task in self.tasks:

self.tasks.remove(task)

def _handle_task_result(self, task_id: str, result: Any):

"""处理任务结果"""

with self.task_lock:

if task_id in self.running_tasks:

del self.running_tasks[task_id]

# 处理结果(简化实现)

print(f"Task {task_id} completed: {result}")

def prioritize_tasks(self, task_priorities: Dict[str, int]):

"""设置任务优先级"""

with self.task_lock:

# 根据优先级排序任务

self.tasks.sort(key=lambda t: task_priorities.get(t.get('task_id'), 0), reverse=True)

def get_task_status(self, task_id: str) -> Dict[str, Any]:

"""获取任务状态"""

with self.task_lock:

if task_id in self.running_tasks:

return {

'status': 'running',

'actor_id': self.running_tasks[task_id][0]

}

for task in self.tasks:

if task.get('task_id') == task_id:

return {

'status': 'pending'

}

return {

'status': 'unknown'

}代码解析:

- 任务提交与调度:负责接收任务并将其分配给合适的Actor。

- 批处理优化:将相似任务合并为批次,提高GPU利用率。

- Actor选择:根据资源使用情况和任务需求,选择合适的Actor执行任务。

- 任务优先级:支持基于优先级的任务调度,保证高优先级任务优先执行。

- 任务状态跟踪:跟踪任务的执行状态,包括待执行、运行中、完成等。

3.5 Ray故障容错实现

vLLM中的Ray故障容错模块负责检测和处理Actor故障:

# vllm/ray_integration/fault_tolerance.py

from typing import Dict, List, Any, Optional

import time

import threading

class RayFaultTolerance:

def __init__(self, config: Dict[str, Any]):

self.config = config

self.actor_heartbeats = {} # actor_id -> last_heartbeat_time

self.failure_count = {} # actor_id -> failure_count

self.is_running = False

self.detection_thread = None

self.heartbeat_timeout = self.config.get('heartbeat_timeout', 10.0)

def start(self):

"""启动故障容错模块"""

self.is_running = True

# 启动故障检测线程

self.detection_thread = threading.Thread(target=self._detection_loop)

self.detection_thread.daemon = True

self.detection_thread.start()

def stop(self):

"""停止故障容错模块"""

self.is_running = False

if self.detection_thread:

self.detection_thread.join()

def update_heartbeat(self, actor_id: str):

"""更新Actor心跳"""

self.actor_heartbeats[actor_id] = time.time()

# 重置故障计数

self.failure_count[actor_id] = 0

def _detection_loop(self):

"""故障检测循环"""

while self.is_running:

time.sleep(self.config.get('detection_interval', 1.0))

self._detect_failures()

def _detect_failures(self):

"""检测故障Actor"""

from vllm.ray_integration.actor_manager import RayActorManager

from vllm.ray_integration.scheduler import RayScheduler

current_time = time.time()

# 检查所有Actor的心跳

for actor_id in list(self.actor_heartbeats.keys()):

last_heartbeat = self.actor_heartbeats[actor_id]

# 检查心跳是否超时

if current_time - last_heartbeat > self.heartbeat_timeout:

# 增加故障计数

self.failure_count[actor_id] = self.failure_count.get(actor_id, 0) + 1

# 超过阈值,标记为故障

if self.failure_count[actor_id] > self.config.get('failure_threshold', 3):

print(f"Actor {actor_id} failed: heartbeat timeout")

# 处理故障

self._handle_failure(actor_id)

def _handle_failure(self, actor_id: str):

"""处理Actor故障"""

from vllm.ray_integration.actor_manager import RayActorManager

from vllm.ray_integration.scheduler import RayScheduler

from vllm.ray_integration.resource_manager import RayResourceManager

# 获取组件实例

actor_manager = RayActorManager.get_instance()

scheduler = RayScheduler.get_instance()

resource_manager = RayResourceManager.get_instance()

if not actor_manager or not scheduler or not resource_manager:

return

# 1. 移除故障Actor

actor_manager.remove_actor(actor_id)

resource_manager.free_resources(actor_id)

# 2. 迁移故障Actor上的任务

self._migrate_tasks(actor_id, scheduler)

# 3. 创建新Actor替换故障Actor

if resource_manager.is_resource_available(

self.config.get('actor_resources', {'CPU': 1, 'GPU': 0})

):

actor_manager.create_worker_actor()

# 4. 更新心跳记录

if actor_id in self.actor_heartbeats:

del self.actor_heartbeats[actor_id]

if actor_id in self.failure_count:

del self.failure_count[actor_id]

def _migrate_tasks(self, actor_id: str, scheduler: RayScheduler):

"""迁移故障Actor上的任务"""

# 简化实现:获取所有运行中任务,重新提交

with scheduler.task_lock:

for task_id, (running_actor_id, future) in list(scheduler.running_tasks.items()):

if running_actor_id == actor_id:

# 取消任务

future.cancel()

# 重新提交任务

task = next(

(t for t in scheduler.tasks if t.get('task_id') == task_id),

None

)

if task:

scheduler.tasks.append(task)

# 从运行中任务列表中移除

del scheduler.running_tasks[task_id]

def get_failure_stats(self) -> Dict[str, Any]:

"""获取故障统计信息"""

return {

'total_actors': len(self.actor_heartbeats),

'failed_actors': len([a for a in self.failure_count if self.failure_count[a] > self.config.get('failure_threshold', 3)]),

'failure_count': self.failure_count

}代码解析:

- 心跳检测:定期检查Actor的心跳,超过阈值则标记为故障。

- 故障处理:处理故障Actor,包括移除故障Actor、迁移任务、创建新Actor等。

- 任务迁移:将故障Actor上的任务重新提交到调度队列,确保任务不丢失。

- 故障统计:统计故障Actor数量和故障次数,为系统优化提供依据。

- 自动恢复:在Actor故障时,自动创建新Actor替换,确保系统可用性。

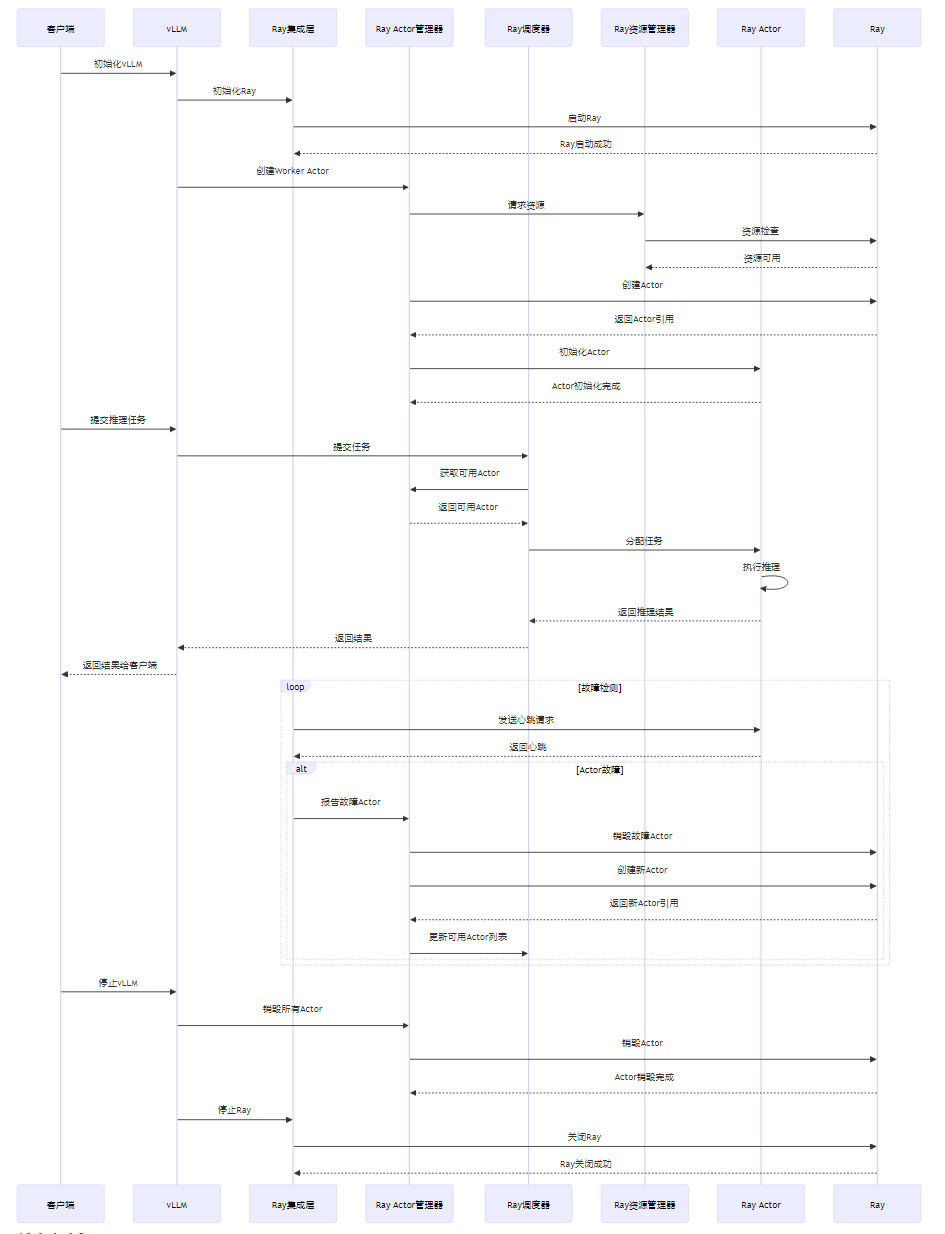

3.6 Ray与vLLM的交互流程

Ray与vLLM的交互流程包括初始化、任务提交、执行和结果返回等阶段:

交互流程解析:

- 初始化阶段:vLLM初始化Ray,创建Worker Actor,准备接收推理任务。

- 任务提交阶段:客户端向vLLM提交推理任务,vLLM将任务传递给Ray调度器。

- 任务执行阶段:Ray调度器将任务分配给合适的Actor,Actor执行推理并返回结果。

- 结果返回阶段:vLLM将推理结果返回给客户端。

- 故障检测阶段:定期检测Actor的健康状态,在Actor故障时自动恢复。

- 停止阶段:vLLM停止时,销毁所有Actor,关闭Ray。

3.7 Ray性能优化策略

vLLM中的Ray性能优化策略包括:

优化策略 | 实现方式 | 预期收益 |

|---|---|---|

批处理优化 | 将相似任务合并为批次,减少Actor通信开销 | 提高吞吐量,减少推理延迟 |

异步通信 | 采用异步通信模式,减少等待时间 | 提高系统响应速度 |

共享内存通信 | 同一节点内Actor通过共享内存通信 | 减少数据拷贝开销,提高通信效率 |

通信压缩 | 对传输的数据进行压缩 | 减少网络带宽占用,提高通信速度 |

资源感知调度 | 根据Actor资源使用情况智能分配任务 | 提高资源利用率,避免热点节点 |

动态批大小 | 根据负载情况动态调整批处理大小 | 平衡吞吐量和延迟 |

模型预热 | Actor启动时预热模型,避免首次请求延迟 | 减少冷启动延迟 |

Actor池管理 | 维护固定大小的Actor池,避免频繁创建和销毁Actor | 减少Actor创建开销 |

4. 与主流方案深度对比

4.1 Ray vs Horovod

特性 | Ray | Horovod |

|---|---|---|

设计目标 | 通用分布式计算框架 | 分布式深度学习训练框架 |

通信机制 | 基于Actor的消息传递 | 基于MPI的集体通信 |

资源管理 | 内置资源管理器,支持动态资源分配 | 依赖外部资源管理器(如Kubernetes) |

故障容错 | 内置故障检测和恢复机制 | 有限的故障容错支持 |

扩展性 | 支持大规模集群,可达数千节点 | 支持大规模集群,但配置复杂 |

易用性 | 简单的Python API,易于使用 | 需要熟悉MPI,学习曲线较陡 |

生态系统 | 丰富的生态系统,支持多种框架 | 主要与TensorFlow、PyTorch等深度学习框架集成 |

灵活性 | 支持多种部署模式,包括单机、集群、云原生等 | 主要用于分布式训练,部署模式相对固定 |

性能 | 高性能,支持RDMA等高速通信 | 高性能,针对深度学习训练优化 |

社区活跃度 | 高,更新频繁 | 中,更新相对较慢 |

4.2 Ray vs DeepSpeed

特性 | Ray | DeepSpeed |

|---|---|---|

设计目标 | 通用分布式计算框架 | 深度学习训练和推理优化框架 |

通信机制 | 基于Actor的消息传递 | 基于NCCL的集体通信 |

资源管理 | 内置资源管理器,支持动态资源分配 | 依赖外部资源管理器 |

故障容错 | 内置故障检测和恢复机制 | 有限的故障容错支持 |

扩展性 | 支持大规模集群,可达数千节点 | 支持大规模模型训练和推理 |

易用性 | 简单的Python API,易于使用 | 需要熟悉DeepSpeed配置,学习曲线较陡 |

生态系统 | 丰富的生态系统,支持多种框架 | 主要与PyTorch集成 |

灵活性 | 支持多种部署模式 | 主要用于深度学习场景 |

性能 | 高性能,支持多种优化技术 | 极高性能,针对深度学习优化 |

社区活跃度 | 高,更新频繁 | 高,与Microsoft深度合作 |

4.3 Ray vs Kubernetes

特性 | Ray | Kubernetes |

|---|---|---|

设计目标 | 分布式计算框架 | 容器编排平台 |

通信机制 | 基于Actor的消息传递 | 基于容器网络的通信 |

资源管理 | 内置资源管理器,支持动态资源分配 | 强大的资源管理和调度能力 |

故障容错 | 内置故障检测和恢复机制 | 强大的故障容错和自愈能力 |

扩展性 | 支持大规模集群,可达数千节点 | 支持超大规模集群,可达数万个节点 |

易用性 | 简单的Python API,易于使用 | 复杂的YAML配置,学习曲线较陡 |

生态系统 | 丰富的生态系统,支持多种框架 | 极其丰富的生态系统,几乎支持所有云原生应用 |

灵活性 | 支持多种部署模式 | 高度灵活,支持各种部署场景 |

性能 | 高性能,针对分布式计算优化 | 性能取决于容器运行时和网络配置 |

社区活跃度 | 高,更新频繁 | 极高,是云原生领域的事实标准 |

4.4 Ray在vLLM中的优势

与其他分布式框架相比,Ray在vLLM中的优势包括:

- 简单易用:Ray提供了简单的Python API,简化了vLLM的分布式部署和管理。

- 高性能:Ray的高效通信机制和资源调度提高了vLLM的推理性能。

- 可扩展性:Ray支持vLLM从单节点到大规模分布式的平滑扩展。

- 可靠性:Ray的故障容错机制提高了vLLM的系统可靠性。

- 灵活性:Ray支持多种部署模式,满足不同场景需求。

- 丰富的生态:Ray丰富的生态系统为vLLM提供了与其他工具和框架的无缝集成能力。

5. 实际工程意义、潜在风险与局限性分析

5.1 实际工程意义

5.1.1 简化分布式部署

Ray简化了vLLM的分布式部署流程,降低了开发和运维成本。通过Ray的API,开发者可以轻松地将vLLM扩展到大规模集群,而无需关心底层的分布式细节。

5.1.2 提高资源利用率

Ray的资源感知调度器能够根据任务需求动态分配资源,提高GPU、CPU等硬件资源的利用率。这对于降低推理成本、提高系统吞吐量具有重要意义。

5.1.3 提高系统可靠性

Ray的故障检测和恢复机制确保vLLM在节点故障时能够自动恢复,提高系统的可靠性和可用性。这对于生产环境中的实时推理服务至关重要。

5.1.4 支持大规模模型推理

Ray支持TB级模型的分布式推理,满足超大模型的推理需求。这使得vLLM能够处理越来越大的模型,适应大模型发展趋势。

5.1.5 促进生态融合

Ray丰富的生态系统为vLLM提供了与其他工具和框架的无缝集成能力,促进了不同生态系统的融合。这有助于vLLM更好地融入AI生态,扩大其应用范围。

5.2 潜在风险与局限性

5.2.1 Ray依赖风险

vLLM对Ray的强依赖可能带来一些风险,如Ray版本兼容性问题、Ray本身的bug等。这可能影响vLLM的稳定性和可靠性。

5.2.2 性能开销

Ray的Actor通信和资源调度可能带来一定的性能开销,尤其是在小规模部署时。这可能影响vLLM的推理延迟。

5.2.3 学习曲线

虽然Ray提供了简单的Python API,但要充分利用Ray的高级特性,如资源调度、故障容错等,仍然需要一定的学习成本。

5.2.4 配置复杂性

Ray的配置选项较多,需要根据具体场景进行优化配置。这可能增加vLLM的部署和管理复杂度。

5.2.5 社区支持

虽然Ray的社区活跃度较高,但与其他成熟框架相比,其社区支持仍然有提升空间。这可能影响vLLM在生产环境中的应用。

5.3 工程实践中的优化建议

5.3.1 Ray配置优化

- 调整Ray资源配置:根据实际硬件情况调整Ray的资源配置,包括CPU、GPU、内存等。

- 优化Ray调度器:调整Ray调度器的参数,如调度间隔、批处理大小等,提高调度效率。

- 启用RDMA:在支持RDMA的环境中,启用RDMA通信,降低通信延迟。

- 配置共享内存:在同一节点内,启用共享内存通信,减少数据拷贝开销。

- 调整心跳参数:根据网络情况调整心跳超时时间和检测间隔,避免误判。

5.3.2 Actor管理优化

- 合理设置Actor数量:根据负载情况和硬件资源,设置合理的Actor数量,避免过多或过少。

- 启用Actor池:维护固定大小的Actor池,避免频繁创建和销毁Actor。

- 优化Actor初始化:使用模型缓存、并行加载等方式,减少Actor初始化时间。

- 监控Actor状态:实时监控Actor的健康状态和资源使用情况,及时发现问题。

- 合理配置Actor资源:根据Actor的实际需求,配置合适的CPU、GPU等资源。

5.3.3 任务调度优化

- 调整批处理大小:根据模型大小和GPU内存,调整批处理大小,平衡吞吐量和延迟。

- 启用优先级调度:对重要任务设置较高优先级,保证其响应时间。

- 优化调度间隔:根据负载情况调整调度间隔,平衡调度开销和响应速度。

- 启用动态批处理:根据实时负载情况,动态调整批处理大小。

- 避免任务饥饿:采用公平调度策略,避免某些任务长期等待。

5.3.4 故障容错优化

- 调整故障检测参数:根据系统特性调整故障检测间隔和故障阈值,提高故障检测的准确性。

- 启用快速恢复:使用预热机制和并行加载技术,减少故障恢复时间。

- 实现优雅降级:在资源不足时,实现优雅降级,保证核心功能可用。

- 备份关键数据:对关键数据进行备份,确保故障恢复时数据不丢失。

- 定期测试故障恢复:定期测试故障恢复机制,确保其在实际故障时能够正常工作。

5.3.5 监控与调试

- 启用详细日志:启用详细的日志记录,便于调试和故障分析。

- 监控关键指标:监控系统的关键指标,如吞吐量、延迟、资源利用率等。

- 使用Ray Dashboard:利用Ray Dashboard监控系统状态和性能。

- 定期性能测试:定期进行性能测试,优化系统配置。

- 实现分布式跟踪:使用分布式跟踪工具,如Jaeger、Zipkin等,跟踪请求的执行路径。

6. 未来趋势展望与个人前瞻性预测

6.1 Ray的发展趋势

6.1.1 更高效的通信机制

未来,Ray将继续优化通信机制,包括:

- RDMA增强:进一步优化RDMA通信,支持更多RDMA设备和拓扑。

- 智能网络感知:根据网络拓扑和负载情况,智能选择通信路径和协议。

- 通信压缩优化:采用更高效的压缩算法,进一步减少网络带宽占用。

- 硬件加速通信:利用专用硬件加速通信,如智能网卡、DPU等。

6.1.2 更智能的资源调度

Ray的资源调度将更加智能:

- 机器学习驱动的调度:使用机器学习模型预测任务执行时间和资源需求,优化调度决策。

- 动态资源预留:根据任务需求,动态预留资源,提高资源利用率。

- 跨节点资源调度:支持跨节点的资源调度,实现更高效的资源利用。

- 异构资源调度:支持CPU、GPU、FPGA等异构资源的协同调度。

6.1.3 更完善的故障容错

Ray的故障容错机制将更加完善:

- 快速故障检测:采用更高效的故障检测算法,减少故障检测时间。

- 智能故障恢复:根据故障类型和系统状态,智能选择最佳恢复策略。

- 状态持久化增强:支持更多类型的状态持久化,便于故障恢复。

- 多级容错:实现更细粒度的容错机制,如任务级、Actor级、节点级的多级容错。

6.1.4 更丰富的生态集成

Ray将进一步扩展其生态系统:

- 与更多框架集成:与更多深度学习框架、大数据处理框架、云原生工具等集成。

- 支持更多硬件:支持更多类型的硬件,如边缘设备、专用AI加速卡等。

- 云厂商深度合作:与各大云厂商深度合作,提供更优化的云原生支持。

- 社区生态繁荣:鼓励社区贡献,丰富Ray的生态系统。

6.1.5 更优化的云原生支持

Ray的云原生支持将更加优化:

- Kubernetes增强:进一步优化与Kubernetes的集成,支持更多Kubernetes特性。

- Serverless支持:支持Serverless部署模式,提高资源利用率和弹性。

- 边缘云协同:支持边缘云协同部署,实现边缘设备和云服务器的协同工作。

- 云资源自动管理:与云厂商的资源管理服务集成,实现云资源的自动管理。

6.2 Ray与vLLM的未来结合

6.2.1 更深度的集成

Ray与vLLM的集成将更加深度:

- 共享内存优化:进一步优化同一节点内的共享内存通信,减少数据拷贝开销。

- 统一资源管理:实现Ray与vLLM的统一资源管理,提高资源利用率。

- 联合调度:实现Ray与vLLM的联合调度,优化任务分配和执行。

- 统一监控:实现Ray与vLLM的统一监控,便于系统管理和优化。

6.2.2 更高效的推理

基于Ray的vLLM推理将更加高效:

- 动态批处理增强:根据实时负载情况,动态调整批处理大小,优化吞吐量和延迟。

- 模型并行优化:优化模型并行策略,支持更大规模的模型推理。

- 流水线并行:实现流水线并行,提高GPU利用率。

- 混合并行:同时使用模型并行、数据并行和流水线并行,进一步提高性能。

6.2.3 更智能的扩缩容

vLLM的动态扩缩容将更加智能:

- 预测性扩缩容:根据历史负载模式,预测未来负载,提前调整Actor数量。

- 自适应扩缩容:根据实时负载情况和资源使用情况,自动调整Actor数量。

- 成本优化:根据云厂商的定价策略,优化资源分配,降低推理成本。

- 多维度扩缩容:支持根据CPU、GPU、内存等多维度资源进行扩缩容。

6.2.4 更完善的故障容错

vLLM的故障容错机制将更加完善:

- 快速故障恢复:优化故障恢复流程,减少故障恢复时间。

- 状态持久化:支持任务状态的持久化,便于故障恢复时恢复任务状态。

- 优雅降级:在资源不足时,实现优雅降级,保证核心功能可用。

- 多级容错:实现任务级、Actor级、节点级的多级容错机制。

6.2.5 更丰富的部署模式

vLLM将支持更多的部署模式:

- 边缘部署:支持在边缘设备上部署vLLM,实现边缘推理。

- 混合部署:支持CPU、GPU、边缘设备等混合部署,实现边缘云协同推理。

- Serverless部署:支持Serverless部署模式,提高资源利用率和弹性。

- 云原生部署:进一步优化云原生部署,支持Kubernetes等云原生环境。

6.3 个人前瞻性预测

6.3.1 Ray将成为分布式推理的主流框架

随着大模型推理需求的不断增长,Ray作为一种通用的分布式计算框架,将在分布式推理领域发挥越来越重要的作用。其简单易用的API、高效的通信机制和资源调度、完善的故障容错机制,使其成为分布式推理的理想选择。

6.3.2 分布式推理将向云原生方向发展

分布式推理将越来越多地采用云原生部署模式,如Kubernetes、Serverless等。这将简化分布式部署流程,提高系统的弹性和可扩展性。

6.3.3 边缘云协同推理将成为趋势

随着边缘计算的兴起,边缘云协同推理将成为一种重要的部署模式。Ray的边缘云协同支持将使vLLM能够在边缘设备和云服务器之间实现高效的协同推理。

6.3.4 机器学习驱动的优化将广泛应用

机器学习技术将广泛应用于分布式推理的各个方面,如资源调度、故障检测、性能优化等。这将使vLLM能够根据实时情况自动调整参数,实现最优性能。

6.3.5 异构计算将成为标配

CPU、GPU、FPGA等异构计算将成为分布式推理的标配。Ray的异构资源调度支持将使vLLM能够充分利用各种硬件资源,提高推理性能。

6.4 给推理工程师的建议

- 深入学习Ray:充分学习Ray的核心概念和高级特性,如Actor模型、资源调度、故障容错等。

- 优化Ray配置:根据具体场景优化Ray的配置,提高vLLM的推理性能。

- 监控系统状态:实时监控vLLM和Ray的系统状态,及时发现和解决问题。

- 合理设计Actor:根据任务需求,合理设计Actor的数量、资源配置和初始化流程。

- 优化任务调度:根据负载情况,优化任务调度策略,提高系统吞吐量和响应速度。

- 实现故障容错:充分利用Ray的故障容错机制,提高vLLM的系统可靠性。

- 关注生态发展:关注Ray和vLLM的生态发展,及时了解最新的技术动态和最佳实践。

- 参与社区贡献:积极参与Ray和vLLM的社区贡献,推动其发展。

7. 总结

本文深入剖析了Ray在vLLM中的核心角色,包括Ray的集成架构、Actor通信机制、资源管理、任务调度、故障容错等方面。通过与主流分布式框架的深度对比,分析了Ray在vLLM中的优势和局限性。同时,探讨了Ray的发展趋势、与vLLM的未来结合以及分布式推理的发展方向。

Ray作为vLLM的分布式推理引擎,为vLLM提供了高效的通信机制、智能的资源调度、完善的故障容错和丰富的生态集成。这使得vLLM能够实现从单节点到大规模分布式的平滑扩展,提高推理性能和系统可靠性。

在实际工程实践中,推理工程师需要深入学习Ray的核心概念和高级特性,优化Ray的配置和Actor设计,合理调整任务调度策略,充分利用Ray的故障容错机制,以提高vLLM的推理性能和系统可靠性。

未来,Ray将继续优化其通信机制、资源调度、故障容错和生态集成,与vLLM实现更深度的结合。分布式推理将向云原生、边缘云协同、机器学习驱动优化、异构计算等方向发展。推理工程师需要关注这些发展趋势,不断更新自己的知识和技能,以适应分布式推理的发展需求。

参考链接:

附录(Appendix):

附录A:Ray 配置参数

参数名称 | 默认值 | 说明 |

|---|---|---|

ray_address | auto | Ray集群地址 |

ray_runtime_env | {} | Ray运行时环境配置 |

actor_resources | {‘CPU’: 1, ‘GPU’: 0} | 每个Actor的资源需求 |

initial_actor_count | 1 | 初始Actor数量 |

schedule_interval | 0.1 | 调度间隔(秒) |

batch_size | 32 | 批处理大小 |

resource_monitor_interval | 5.0 | 资源监控间隔(秒) |

heartbeat_timeout | 10.0 | 心跳超时时间(秒) |

detection_interval | 1.0 | 故障检测间隔(秒) |

failure_threshold | 3 | 故障计数阈值 |

enable_rdma | False | 是否启用RDMA通信 |

enable_shared_memory | True | 是否启用共享内存通信 |

communication_compression | False | 是否启用通信压缩 |

附录B:vLLM Ray 部署示例

from vllm import LLM, SamplingParams

from vllm.ray_integration import RayLLM

# 配置Ray

ray_config = {

'ray_address': 'auto',

'initial_actor_count': 4,

'actor_resources': {'CPU': 2, 'GPU': 1},

'batch_size': 32,

'enable_shared_memory': True

}

# 创建RayLLM实例

llm = RayLLM(

model='meta-llama/Llama-2-70b-hf',

ray_config=ray_config,

dtype='float16',

trust_remote_code=True

)

# 配置采样参数

sampling_params = SamplingParams(

temperature=0.7,

top_p=0.95,

max_tokens=100

)

# 生成文本

prompts = [

"Hello, how are you?",

"What's the capital of France?",

"Explain quantum computing in simple terms."

]

# 异步生成

outputs = llm.generate(prompts, sampling_params)

# 打印结果

for output in outputs:

prompt = output.prompt

generated_text = output.outputs[0].text

print(f"Prompt: {prompt}")

print(f"Generated text: {generated_text}")

print("=" * 50)

# 关闭LLM

llm.shutdown()附录C:Ray 监控与调试命令

启动Ray Dashboard:

ray dashboard --address=auto查看Ray节点状态:

ray status查看Ray日志:

ray logs --tail=100 raylet监控Ray性能:

ray timeline调试Ray Actor:

ray inspect-actor <actor_id>查看Ray资源使用情况:

ray resources关键词: Ray, vLLM, 分布式推理, Ray Actor, 资源管理, 任务调度, 故障容错, 性能优化, 云原生, 边缘云协同

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2026-01-29,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录