【计算机视觉】深入理解Transformer:架构、原理与视觉应用

【计算机视觉】深入理解Transformer:架构、原理与视觉应用

果粒蹬

发布于 2026-01-23 19:34:53

发布于 2026-01-23 19:34:53

【计算机视觉】深入理解Transformer:架构、原理与视觉应用

在这里插入图片描述

引言:自2017年Vaswani等人提出Transformer架构以来,这一以自注意力机制为核心的模型彻底重塑了自然语言处理(NLP)领域的技术格局。随着研究的深入,Transformer的强大建模能力逐渐突破模态界限,成功迁移至计算机视觉(CV)领域,引发了从“局部归纳偏置”到“全局序列建模”的范式变革。从Vision Transformer(ViT)首次证明纯Transformer在图像分类任务中的可行性,到Swin Transformer成为通用视觉骨干网络,再到DETR颠覆目标检测的传统 pipeline,Transformer正持续推动CV领域的技术革新。本文将系统梳理Transformer的架构起源、核心组件原理、与传统CNN的对比差异,以及在视觉任务中的典型应用,并探讨当前面临的挑战与未来发展方向,助力读者全面深入理解这一革命性架构。

一、Transformer的起源:从NLP到CV的跨模态迁移

1.1 起源:NLP领域的范式革新

在Transformer出现之前,NLP领域的主流模型以循环神经网络(RNN)及其变体(LSTM、GRU)为主。这类模型采用时序迭代的方式处理文本序列,天然存在两个核心缺陷:一是无法并行训练,导致训练效率低下;二是长距离依赖建模能力有限,难以捕捉文本中远距离的语义关联。2017年,Vaswani等人在《Attention Is All You Need》一文中提出了完全基于注意力机制的Transformer架构,彻底摒弃了循环结构。其核心创新在于通过自注意力机制实现序列元素间的全局交互,并借助多头注意力、位置编码等组件,在保持建模能力的同时实现了高效的并行训练。Transformer迅速成为NLP领域的主流架构,基于其衍生的BERT、GPT等模型不断刷新各类NLP任务的性能纪录,开启了NLP的大模型时代。

1.2 迁移:跨越模态的技术突破

与NLP领域不同,CV领域长期以来被卷积神经网络(CNN)所主导。CNN通过局部卷积操作、权重共享和池化层,构建了强大的局部特征提取能力,其固有的平移不变性和局部性归纳偏置非常适配图像的空间结构特性,在图像分类、目标检测、语义分割等任务中取得了巨大成功。但CNN的局限性也逐渐凸显:感受野的扩张依赖于网络深度的堆叠,难以建立真正的长距离全局依赖;层次化特征提取过程中易丢失细节信息,对需要全局语义关联的任务(如场景理解、细粒度识别)适配性有限。

二、Transformer核心组件详解

Transformer的核心结构分为编码器(Encoder)和解码器(Decoder),其中编码器由多层相同的层堆叠而成,每层包含自注意力层和前馈网络层;解码器在编码器的基础上增加了交叉注意力层。对于CV领域的大多数应用(如图像分类、语义分割),通常仅需使用编码器结构。以下将详细解析Transformer的核心组件原理。

2.1 自注意力机制(Self-Attention):全局交互的核心

自注意力机制是Transformer的灵魂,其核心思想是:序列中的每个元素(Token)都能与序列中所有其他元素直接交互,通过计算元素间的相关性(注意力权重),动态聚合全局信息,生成富含全局语义的特征表示。其数学原理可通过以下三步实现:

- 线性变换生成Query、Key、Value:对于输入序列向量X = [x₁, x₂, …, xₙ](n为序列长度),通过三个独立的线性层将每个xᵢ分别映射为Query(查询向量,记为Q)、Key(键向量,记为K)和Value(值向量,记为V),即 Q = XWᵠ、K = XWᵏ、V = XWᵛ,其中Wᵠ、Wᵏ、Wᵛ为可学习的权重矩阵。

- 计算注意力权重:通过Query与Key的点积计算元素间的相关性,为避免点积结果过大导致softmax梯度消失,将结果除以√dₖ(dₖ为Key向量的维度),再通过softmax函数归一化得到注意力权重矩阵,即 Attention Weight = softmax(QKᵀ/√dₖ)。权重矩阵中的每个元素αᵢⱼ表示第i个元素对第j个元素的关注程度。

- 聚合Value生成输出:将注意力权重矩阵与Value矩阵相乘,聚合所有元素的信息,得到自注意力层的输出,即 Attention(Q, K, V) = softmax(QKᵀ/√dₖ)V。

在这里插入图片描述

自注意力机制的优势在于:一是具备全局感受野,无需依赖网络深度即可直接捕捉序列中任意两个元素的关联;二是动态权重分配,注意力权重随输入内容动态调整,能自适应不同场景的特征需求;三是可解释性强,通过可视化注意力权重矩阵,可直观观察模型关注的区域。

2.2 多头注意力(Multi-Head Attention):多尺度特征的融合

多头注意力是对自注意力机制的扩展,其核心思想是通过多个并行的自注意力“头”(Head),分别捕捉不同尺度、不同类型的特征关联,再将各头的输出融合,提升模型的表达能力。具体实现过程为:

- 将Q、K、V通过不同的线性层拆分为h个并行的子向量(每个子向量维度为dₖ/h);

- 每个子向量分别执行自注意力计算,得到h个注意力输出;

- 将h个输出拼接,通过一个线性层进行融合,得到多头注意力的最终输出,即 MultiHead(Q, K, V) = Concat(Head₁, Head₂, …, Headₕ)Wᵒ,其中Wᵒ为融合权重矩阵。

多头注意力的价值在于:不同头可专注于不同的特征模式(如在CV任务中,部分头关注局部纹理特征,部分头关注全局语义关联),通过多尺度特征融合,使模型能更全面地捕捉输入数据的复杂信息。

2.3 位置编码(Positional Encoding):序列顺序的补充

自注意力机制本身不具备捕捉序列顺序的能力——将序列元素的顺序打乱后,自注意力的计算结果保持不变,这与NLP中的文本顺序依赖、CV中的图像空间位置依赖需求相悖。为解决这一问题,Transformer引入了位置编码,通过向输入序列中注入位置信息,使模型能够感知元素的顺序关系。

位置编码的设计需满足两个条件:一是不同位置对应不同的编码向量;二是编码向量的差值具有固定性,以适应不同长度的序列。Vaswani等人提出的正弦-余弦位置编码是应用最广泛的方案,其计算公式为:

PE(pos, 2i) = sin(pos / 10000^(2i/dₘₒₙₑ))

PE(pos, 2i+1) = cos(pos / 10000^(2i/dₘₒₙₑ))

其中pos为序列元素的位置索引,i为编码向量的维度索引,dₘₒₙₑ为模型输入维度。这种编码方式通过正弦和余弦函数的周期性变化,使不同位置的编码向量具有明确的位置差异,且能通过三角函数的性质自然扩展到任意长度的序列。在CV任务中,位置编码通常与图像块的空间位置相对应,向图像块序列中注入空间位置信息。

三、Transformer与传统CNN的对比:优势、劣势及互补性

Transformer与CNN作为CV领域的两大核心架构,分别基于“全局序列建模”和“局部归纳偏置”的设计理念,各有优劣。深入理解二者的差异与互补性,对于选择合适的模型架构、设计混合模型具有重要意义。

3.1 优势对比

Transformer相对CNN的核心优势在于全局建模能力和动态适应性:

- 全局依赖建模:Transformer通过自注意力机制直接实现序列元素间的全局交互,无需像CNN那样通过堆叠卷积层和池化层逐步扩张感受野,能更高效、更直接地捕捉长距离的特征关联,在场景理解、细粒度识别等需要全局语义信息的任务中表现更出色。

- 动态权重分配:Transformer的注意力权重随输入内容动态调整,能自适应不同图像的特征分布(如对目标区域分配更高的注意力权重),而CNN的卷积核权重固定,对复杂场景的适应性相对较弱。

- 跨模态统一潜力:Transformer的序列建模范式可同时适配文本、图像、音频等多种模态数据,为构建多模态统一大模型(如CLIP、DALL-E)奠定了基础,而CNN难以直接迁移至非视觉模态。

CNN相对Transformer的核心优势在于局部特征提取效率和数据经济性:

- 高效的局部特征提取:CNN的卷积操作通过权重共享实现局部区域的特征提取,计算复杂度为O(n)(n为图像像素数),而Transformer的自注意力机制计算复杂度为O(n²),在处理高分辨率图像时,CNN的计算效率更具优势。

- 内置归纳偏置适配视觉特性:CNN的平移不变性和局部性归纳偏置天然适配图像的空间结构特性(图像中相邻像素的相关性更强),使其在小规模数据集上能快速学习到有效的特征表示,不易过拟合。

- 成熟的工程化支持:CNN经过多年的发展,已形成完善的工程化优化方案(如卷积加速、量化压缩),在端侧部署的兼容性和效率上更具优势,而Transformer由于参数量大、计算复杂度高,端侧部署仍面临挑战。

3.2 劣势对比

Transformer的主要劣势集中在计算效率、数据依赖和归纳偏置缺失:

- 计算复杂度高:自注意力机制的O(n²)计算复杂度导致Transformer在处理高分辨率图像时计算开销巨大,难以直接应用于目标检测、语义分割等需要高分辨率特征的任务(需通过图像分块、稀疏注意力等方式优化)。

- 数据依赖严重:Transformer缺乏CNN那样的内置归纳偏置,需要大规模标注数据进行预训练才能充分发挥性能,在小规模数据集上的表现通常不及CNN。

- 缺乏平移不变性:Transformer本身不具备平移不变性,需要通过数据增强或位置编码等方式间接弥补,而CNN通过卷积权重共享天然具备这一特性。

CNN的主要劣势在于全局建模能力有限和跨模态适配性差:

- 长距离依赖建模困难:CNN的感受野扩张依赖网络深度,深层网络易出现梯度消失、特征退化等问题,难以有效捕捉长距离的特征关联,对全局语义任务的适配性有限。

- 跨模态迁移能力弱:CNN的局部卷积设计是为视觉数据量身定制的,难以直接迁移至文本、音频等其他模态,无法支撑多模态统一建模。

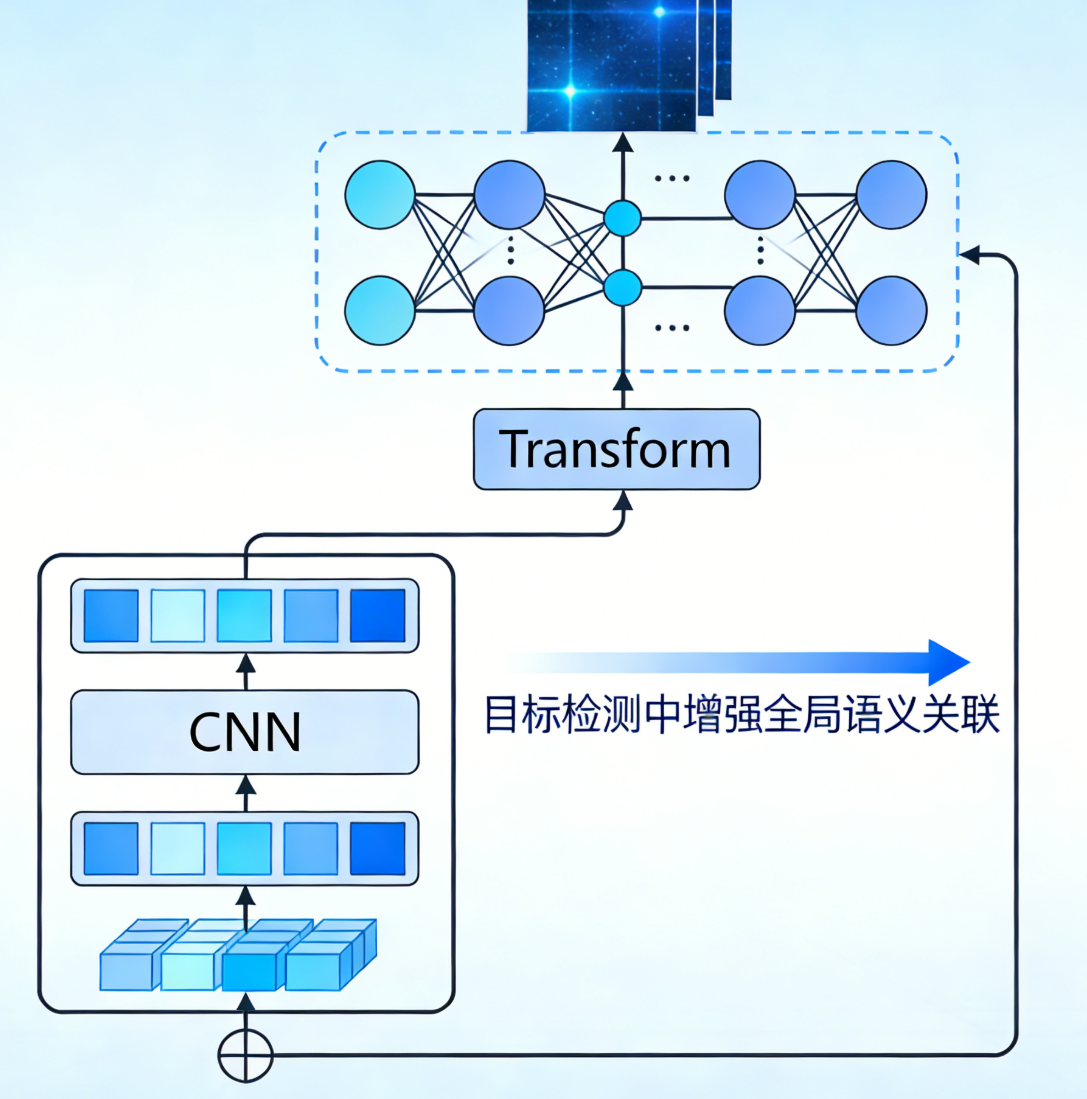

3.3 互补性与融合趋势

Transformer与CNN的劣势恰好是对方的优势,因此二者的融合成为提升模型性能的重要方向。目前主流的融合思路包括:

- CNN辅助Transformer训练:通过知识蒸馏将CNN的归纳偏置传递给Transformer,降低其数据依赖。例如,DeiT引入蒸馏Token,让Transformer学习教师CNN的特征表示,仅使用ImageNet-1k数据集即可训练出高性能模型。

- 混合架构设计:在模型中同时引入CNN的局部卷积和Transformer的全局注意力。例如,ConvNeXt将CNN的卷积层设计为类似Transformer的块结构,提升全局建模能力;MobileViT将图像块通过卷积提取局部特征后,再输入Transformer编码器进行全局建模。

- Transformer作为CNN骨干的增强模块:在CNN骨干网络的顶层加入Transformer模块,增强全局语义关联建模。例如,在目标检测模型中,将CNN提取的特征输入Transformer编码器,提升目标间的关系建模能力。

在这里插入图片描述

四、Transformer在视觉任务中的典型应用

自ViT证明可行性以来,Transformer在CV领域的应用迅速扩展,从图像分类到目标检测、语义分割,再到图像生成、视频理解,各类基于Transformer的模型不断刷新任务性能纪录。以下将介绍几个具有里程碑意义的典型应用。

4.1 Vision Transformer(ViT):纯Transformer在图像分类的突破

ViT是2020年由Dosovitskiy等人提出的首个纯Transformer图像分类模型,其核心创新是将图像转化为序列数据,直接复用标准Transformer编码器。其核心流程为:

- 图像分块嵌入:将输入图像(如224×224)分割为固定大小的图像块(如16×16),每个图像块展平为一维向量(维度为16×16×3=768),通过线性层映射为固定维度的Patch Token(如768维)。

- 添加特殊Token:引入一个可学习的Class Token,用于聚合全局特征并输出分类结果;同时添加位置编码,注入空间位置信息。

- Transformer编码:将Patch Token、Class Token与位置编码的拼接结果输入Transformer编码器,通过多层自注意力和前馈网络进行特征学习。

- 分类输出:取Class Token经过编码器后的特征,通过全连接层输出分类结果。

4.2 Swin Transformer:视觉通用骨干网络的突破

2021年,Liu等人提出的Swin Transformer解决了ViT在高分辨率图像处理和多视觉任务适配性上的缺陷,成为首个可媲美甚至超越CNN的视觉通用骨干网络。其核心创新包括:

- 层级化结构设计:借鉴CNN的层次化特征提取思路,Swin Transformer通过“窗口合并”(Patch Merging)操作逐步降低特征图分辨率、提升通道数,构建多尺度特征表示。这种结构与现有CV任务的Pipeline(如FPN、U-Net)无缝衔接,可直接应用于目标检测、语义分割等需要多尺度特征的任务。

- 滑动窗口注意力:在每层中,自注意力计算仅在不重叠的局部窗口内进行,将计算复杂度从O(n²)降至O(n),大幅提升了高分辨率图像的处理效率。

- 移位窗口机制:为解决局部窗口间缺乏交互的问题,Swin Transformer在相邻层间采用窗口移位策略,使上一层的窗口边界与下一层错位,实现不同窗口间的特征交互,在保持效率的同时获得了全局建模能力。

Swin Transformer在图像分类、目标检测、语义分割等多个CV任务中均取得了SOTA性能,证明了Transformer作为视觉通用骨干网络的潜力,彻底改变了CV领域的架构格局。

4.3 DETR:目标检测的End-to-End革命

传统目标检测模型(如Faster R-CNN、YOLO)依赖手工设计的Anchor框、非极大值抑制(NMS)等后处理步骤,导致模型流程复杂、调参难度大。2020年,Carion等人提出的DETR(Detection Transformer)首次将Transformer应用于目标检测,构建了端到端的目标检测框架,彻底摒弃了Anchor框和NMS。

DETR的核心流程为:

- CNN特征提取:通过CNN骨干网络(如ResNet)提取图像的高维特征图。

- 特征展平与编码:将特征图展平为序列,通过位置编码注入空间信息,输入Transformer编码器进行全局特征增强。

- 解码器与查询匹配:Transformer解码器接收一组可学习的查询向量(Query),通过交叉注意力机制与编码器输出的特征交互,直接预测目标的边界框和类别。

- 二分图匹配损失:通过匈牙利算法实现预测框与真实框的最优匹配,直接计算匹配后的损失,实现端到端训练。

DETR的创新之处在于用Transformer的全局建模能力替代了传统的Anchor框设计,简化了目标检测的流程,且在大目标检测任务中表现出色。后续的Deformable DETR通过引入可变形注意力机制,进一步提升了小目标检测性能和计算效率,推动了Transformer在目标检测领域的广泛应用。

4.4 其他典型应用

除上述核心应用外,Transformer在CV领域的应用已全面铺开:

- 图像生成:基于Transformer的自回归生成模型(如iGPT)和扩散模型(如DiT)在图像生成任务中展现出强大的创造力,能生成高分辨率、高保真的图像。

- 视频理解:时空Transformer(如TimeSformer)通过在时间和空间两个维度分别计算注意力,有效建模视频中的长时序依赖,在动作识别、视频分割等任务中取得突破。

- 语义分割:基于Swin Transformer的U-PerNet、SegViT等模型,通过层级化特征和全局注意力,提升了语义分割的边界精度和全局一致性。

- 多模态学习:CLIP、DALL-E等模型基于Transformer构建视觉-语言统一架构,实现了图像与文本的跨模态对齐,推动了零样本学习、跨模态生成等任务的发展。

五、总结

Transformer架构从NLP领域跨模态迁移至CV领域,引发了一场深刻的技术革命,彻底改变了CV领域的建模范式。其核心优势在于强大的全局建模能力和动态适应性,通过自注意力、多头注意力等组件,实现了对复杂特征关联的高效捕捉。从ViT证明纯Transformer在图像分类的可行性,到Swin Transformer成为通用视觉骨干,再到DETR重构目标检测流程,Transformer在各类CV任务中展现出巨大的潜力。

同时,我们也应清醒地认识到,Transformer仍面临计算效率、数据依赖、可解释性等挑战,与CNN的深度融合仍是提升模型性能的重要方向。未来,随着高效架构设计、轻量化优化、小样本学习等技术的发展,Transformer将在端侧部署、特定领域应用等方面取得更大突破,同时推动多模态统一大模型的发展,为计算机视觉乃至通用人工智能的进步奠定坚实基础。对于研究生和工程师而言,深入理解Transformer的架构原理与应用场景,把握其发展趋势,将是提升技术竞争力的关键。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2026-01-23,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录