kNN与Logistic回归

kNN与Logistic回归

提问于 2019-10-12 06:13:16

你好,我把这个问题设为任选作业,并想征求一些意见。

假设一个人取一个数据集,将其分成训练和测试数据集,然后尝试两种不同的分类过程。首先采用logistic回归方法,对训练数据和测试数据的误差率分别为20%和30%。接下来,他们使用1近邻,平均错误率(在测试和训练数据集上的平均错误率)为18%。根据这些数字,你更喜欢哪种方法用于分类目的(新的观测)?为什么?

我倾向于说kNN,因为它是一种相当灵活的方法,平均提供了一个较低的错误。但这听起来不够正式,可能是一个有缺陷的、天真的结论。有意见吗?

回答 2

Data Science用户

发布于 2019-10-12 07:23:01

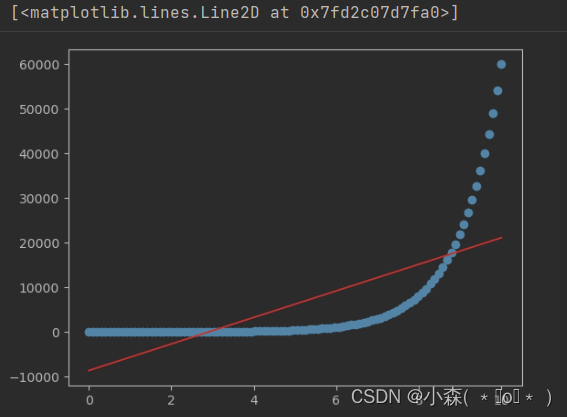

提示:在任何训练集上,一个最近邻的错误率是多少?

从此,确定此数据集上的测试错误。

Data Science用户

发布于 2019-11-11 09:18:54

当训练数据集的大小接近无穷大时,最近邻分类器保证错误率不超过Bayes错误率的两倍(在数据分布的情况下,最小可达错误率)。

我不喜欢他们没有给出两者在KNN中的错误率,他们给出了平均错误率。这让我想到,如果训练数据的准确率为95%,但测试的准确性很差,那么两者的平均误差都是18%。

也许他们想让你认为30-20=10 10*2=20 20>18

页面原文内容由Data Science提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://datascience.stackexchange.com/questions/61639

复制相关文章

相似问题

![[机器学习实战札记] Logistic回归](https://ask.qcloudimg.com/http-save/yehe-1927950/1yabb8jbbk.jpeg)